Model O3 AI Openai uzyskał niżej w odniesieniu Frontiermath niż firma początkowo sugerowała, zgodnie z niezależnymi testami przez Epoch AIInstytut Badawczy stojący za Frontiermath. Kiedy Openai zaprezentował O3 w grudniu, twierdził, że model może odpowiedzieć na 25% pytań Frontiermath, znacznie przewyższając inne modele.

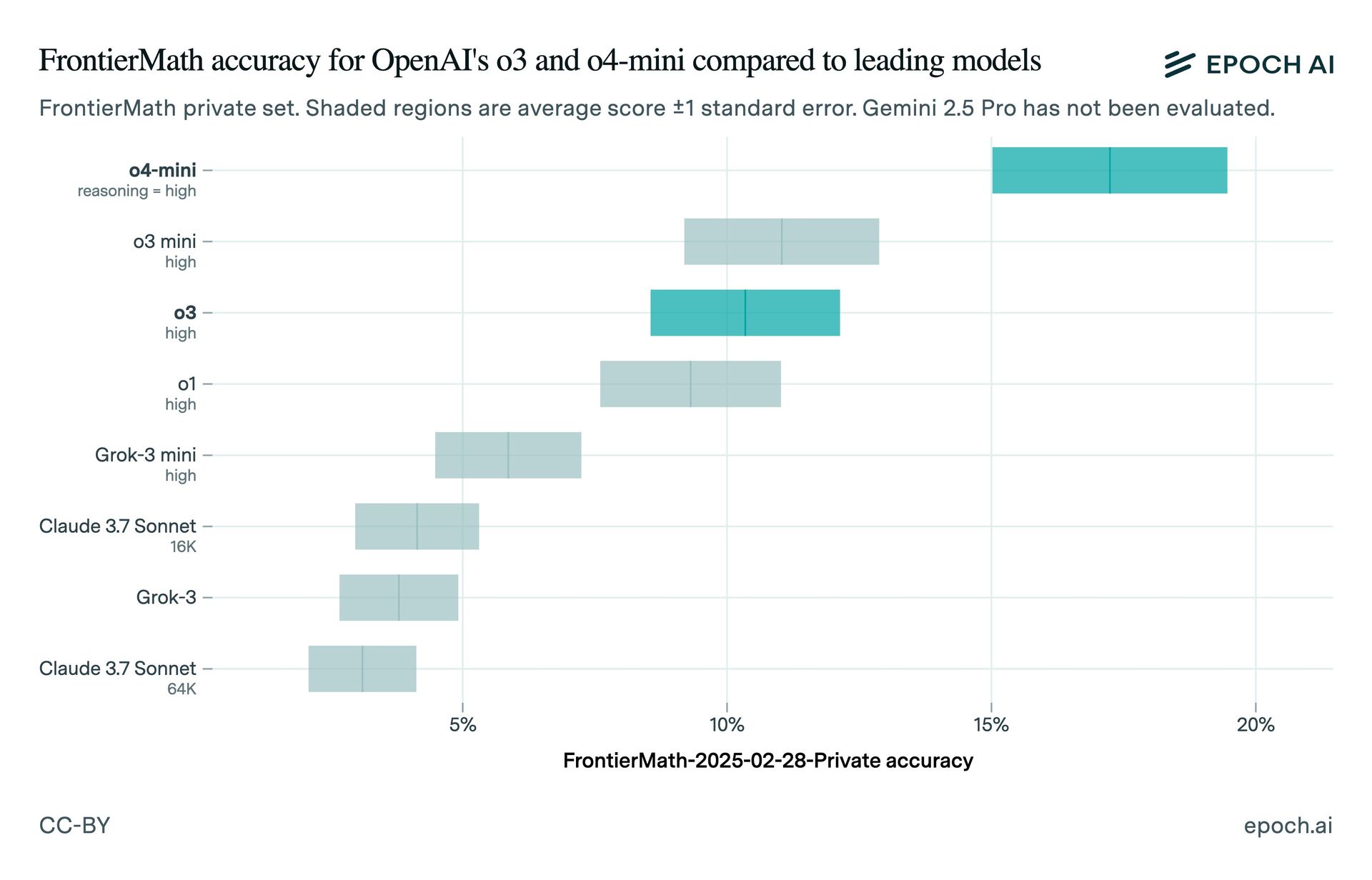

Testy Epoch Ai to znalazły o3 zdobył około 10% na Frontiermath. Rozbieżność może być spowodowana różnicami w konfiguracjach testowych lub używanej wersji O3. Główny oficer badawczy Openai, Mark Chen, miał stwierdził to O3 osiągnął ponad 25% w „agresywnych ustawieniach obliczeniowych czasu testowego”. Epoch zauważył, że opublikowane wyniki Benchmarku Openai wykazały niższy wynik, który pasuje do obserwowanej epoki wyniku 10%.

Publiczny model O3 jest „dostrojony do użytku czat/produkt” i ma mniejsze poziomy obliczeniowe niż wersja testowana przez Openai w grudniu, zgodnie z Fundacją ARC Nagroda, która przetestowała wersję O3 przedpremierową. Wenda Zhou Openai wyjaśnił że produkcyjny model O3 jest „bardziej zoptymalizowany pod kątem rzeczywistych przypadków użycia” i prędkości, co może skutkować różnicami porównawczymi.

Modele O3-Mini i O4-Mini Openai przewyższają O3 na Frontiermath. Firma planuje wydać silniejszy wariant O3, O3-PRO, w nadchodzących tygodniach. Ten incydent podkreśla potrzebę ostrożności podczas interpretacji punktów odniesienia AI, szczególnie gdy są one wykorzystywane do promowania produktów komercyjnych.

Branża AI ostatnio widziała kilka kontrowersji porównawczych. W styczniu Epoch został skrytykowany za to, że nie ujawniła funduszy z Openai, dopóki firma ogłosiła O3. XAI został oskarżony o publikowanie wprowadzających w błąd wykresów porównawczych dla swojego modelu Grok 3, a Meta przyznał się do reklamowania wyników porównawczych dla innej wersji modelu niż ta dostępna dla programistów.