Badacze nasion Bytetedance wdrożyli wartość rozszerzoną bliższą optymalizacją polityki (VAPO), ramy szkolenia uczenia się wzmocnienia zaprojektowane w celu wyostrzenia rozumowania dużych modeli języków na złożonych, długich zadań, osiągając nowe najnowocześniejsze wyniki w odniesieniu AIME24.

Szkolenie LLM dla skomplikowanego rozumowania przy użyciu uczenia się wzmocnienia opartego na wartości, które wcześniej miały do czynienia z znaczącymi przeszkodami. Metody zmagały się z odchyleniem modelu wartości, skutecznie dostosowując się do sekwencji odpowiedzi o bardzo różnej długości i zarządzanie rzadkimi sygnałami nagrody, szczególnie w zadaniach opartych na weryfikatorach, zapewniając tylko binarne informacje zwrotne.

VAPO zajmuje się tymi wyzwaniami poprzez trzy podstawowe innowacje: szczegółowe ramy szkoleń oparte na wartości, dostosowujące się do ogólnej wartości szacunkowej (GAE) dostosowujące parametry oparte na długości odpowiedzi oraz systematyczną integrację technik z wcześniejszych badań.

Ta kombinacja tworzy system, w którym ulepszenia działają synergistycznie. Korzystając z modelu QWEN2.5-32B bez określonych danych SFT, VAPO poprawił wyniki porównawcze od 5 do 60, przewyższając poprzednie najnowocześniejsze metody o 10 punktów.

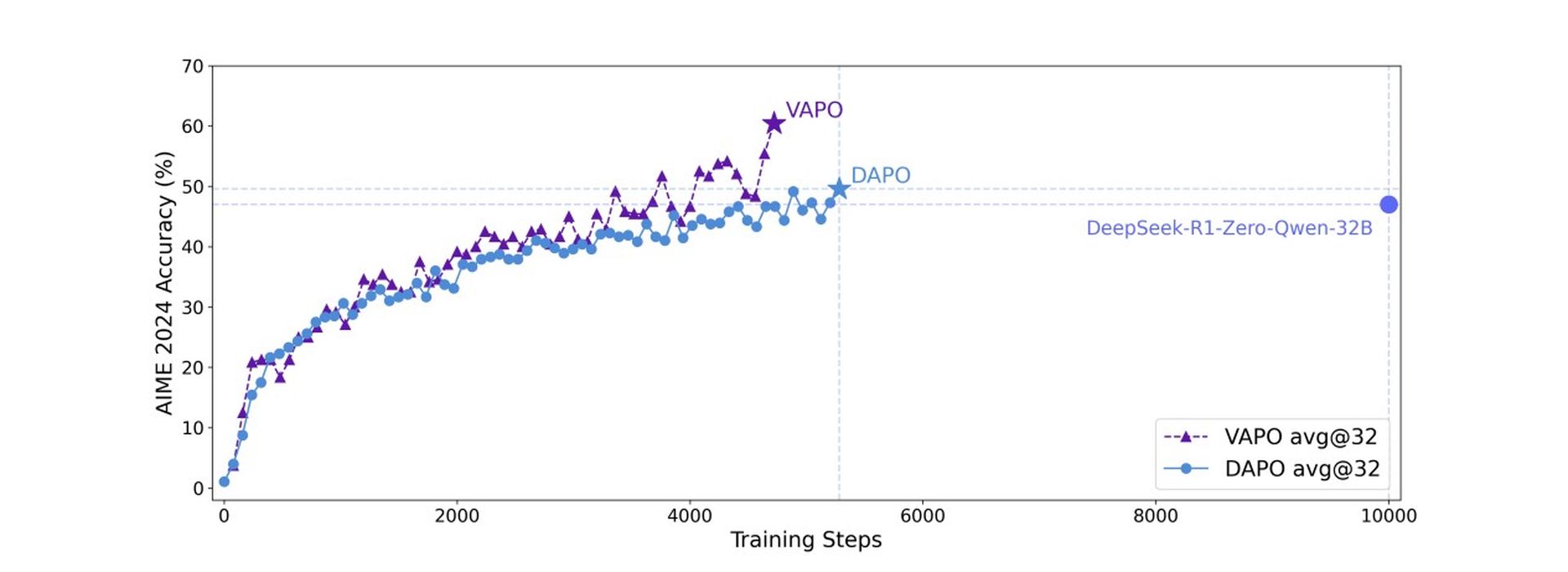

VAPO opiera się na algorytmie bliższej optymalizacji polityki (PPO), ale zawiera kluczowe modyfikacje w celu zwiększenia rozumowania matematycznego. Analiza treningowa ujawniła, że VAPO wykazuje gładsze krzywe treningowe w porównaniu z metodą DAPO bez wartości, co wskazuje na bardziej stabilną optymalizację.

VAPO wykazało również lepszą skalowanie długości w celu poprawy uogólnienia, szybszego wzrostu wyniku przypisywania ziarnistości sygnałów z modelu wartości i niższej entropii na późniejszych etapach treningu. Podczas gdy zmniejszona entropia może potencjalnie ograniczyć eksplorację, metoda skutecznie to równoważy, poprawiając odtwarzalność i stabilność przy minimalnym wpływie wydajności.

W odniesieniu AIME24 Deepseek R1 przy użyciu GRPO osiągnął 47 punktów, a Dapo osiągnął 50 punktów. VAPO, korzystając z modelu QWEN-32B, dopasowało wydajność DAPO z zaledwie 60% kroków aktualizacji i ustalił nowy najnowocześniejszy wynik 60,4 w 5 000 kroków. Natomiast waniliowy PPO uzyskał zaledwie 5 punktów z powodu załamania uczenia się modelu wartości.

Ten punkt odniesienia pyta, czy sztuczna inteligencja może myśleć jak inżynier

Badania ablacyjne potwierdziły skuteczność siedmiu różnych modyfikacji w VAPO. Preferowanie wartości zapobiega załamaniu modelu; Oddzielony GAE umożliwia pełną optymalizację długich odpowiedzi; Adaptacyjny GAE równoważy krótką i długą optymalizację reakcji; Clip-Higher zachęca do dokładnej eksploracji; Utrata poziomu tokena zwiększa ważenie dla długich odpowiedzi; Uwzględnianie pozytywnej utraty LM dodało 6 punktów; a próbkowanie grupy przyczyniło się do 5 punktów do końcowego wyniku.

Badacze atrakcja To VAPO, wykorzystując model QWEN2.5-32B, pokazuje, że to podejście oparte na wartości może zdecydowanie przewyższyć metody wolne od wartości, takie jak GRPO i DAPO, ustanawiając nowy poziom wydajności dla złożonych zadań rozumowania i rozwiązywanie podstawowych wyzwań w modelach wartości szkoleniowej dla długich scenariuszy łańcucha.