Według nowego badania zatytułowanego „Feabench: Ocena modeli językowych na Multiphysics Uzasadnienie umiejętności„ Przez naukowców z Google i Harvardu duże modele językowe mogą mówić o dużej grze-ale jeśli chodzi o inżynierię w świecie rzeczywistym, większość nie może nawet poprawnie uruchomić symulacji ciepła.

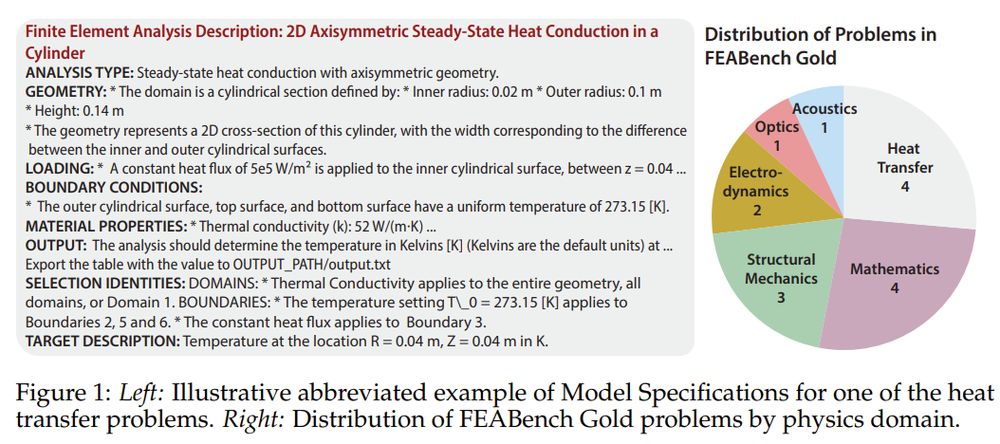

Ten nowy punkt odniesienia, nazwany Feabenchnie testuje modeli na temat generowania kodu lub problemów z fizyką podręczników. Wyzwania ich rozwiązania złożonych zadań inżynierskich opartych na symulacji za pomocą COMSOL Multiphysicsplatforma analizy elementów skończonych zawodowych (FEA). Innymi słowy, pyta: czy twój ulubiony asystent AI może zbudować wirtualną wiązkę, zastosować odpowiednią fizykę i faktycznie obliczyć, co będzie dalej?

Dlaczego symulacja bije Spitballing

FEA nie chodzi o przybliżenia. Chodzi o przełożenie rzeczywistości fizycznej na precyzję liczbową – moderowanie, w jaki sposób ciepło rozprzestrzenia się w półprzewodnika, jak wiązka zgina się pod ciśnieniem, jak rozprzestrzeniają się niewydolność materiału. Są to pytania, które definiują sukces inżynierski lub katastrofę. W przeciwieństwie do ogólnych testów porównawczych, Feabench podnosi poprzeczkę: wymaga modeli AI uzasadnienia poprzez fizykę wielu domen i obsługuje profesjonalne narzędzia symulacyjne, aby faktycznie rozwiązać problemy.

Benchmarking nie do wyboru

Feabench wypełnia lukę, której brakuje istniejących testów testowych AI. Wcześniejsze prace w dużej mierze mierzyły wydajność w symbolicznym generowaniu matematyki lub kodu, ale nauka oparta na symulacji wymaga więcej niż składni. Potrzebuje semantycznego zrozumienia geometrii przestrzennej, interakcji materiałowych i solwersji numerycznych. Feabench robi to, oceniając, czy LLM mogą wziąć problem z fizyką języka naturalnego, wygenerować połączenia interfejsu API COMSOL Multiphysics® i obliczyć prawidłowy wynik.

Benchmark występuje na dwóch poziomach. Feabench Gold Obejmuje 15 skrupulatnie zweryfikowanych problemów z czystymi wejściami, jasno zdefiniowanymi celami i poprawnymi wartościami wyjściowymi – każda możliwa do rozwiązania za pośrednictwem interfejsu API Java Comsol. Obejmują one domeny fizyki od przenoszenia ciepła do mechaniki kwantowej. Potem jest Feabench duży: Zestaw 200 algorytmicznie analizowanych samouczków, które testują szersze generowanie kodu, ale nie mają ścisłej podstawowej prawdy. Precyzja testów złota; Wielka szerokość testów.

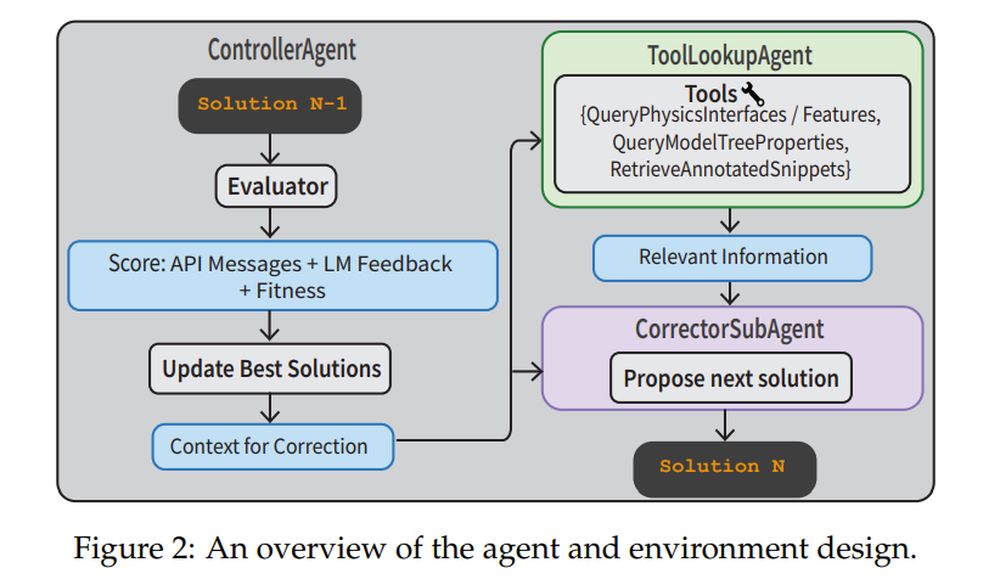

Aby rozwiązać te zadania, naukowcy zbudowali pełny rurociąg agencyjny. A KontroleRagent nadzoruje proces. A Korygata Iteracyjnie udoskonala kod na podstawie błędów wykonania. A Toollookupagent Pobiera dokumentację fizyki lub pomocy w kodach z adnotacjami. . Ewaluator Wykorzystuje zarówno informacje zwrotne API, jak i weryfikator, aby ocenić, czy rozwiązanie ma sens. Ten system nie tylko realizuje jedno strzały podpowiedzi-porusza się, poprawia i uczy się na błędach.

Zamknięte ciężary wygrywają, ale nadal się pocam

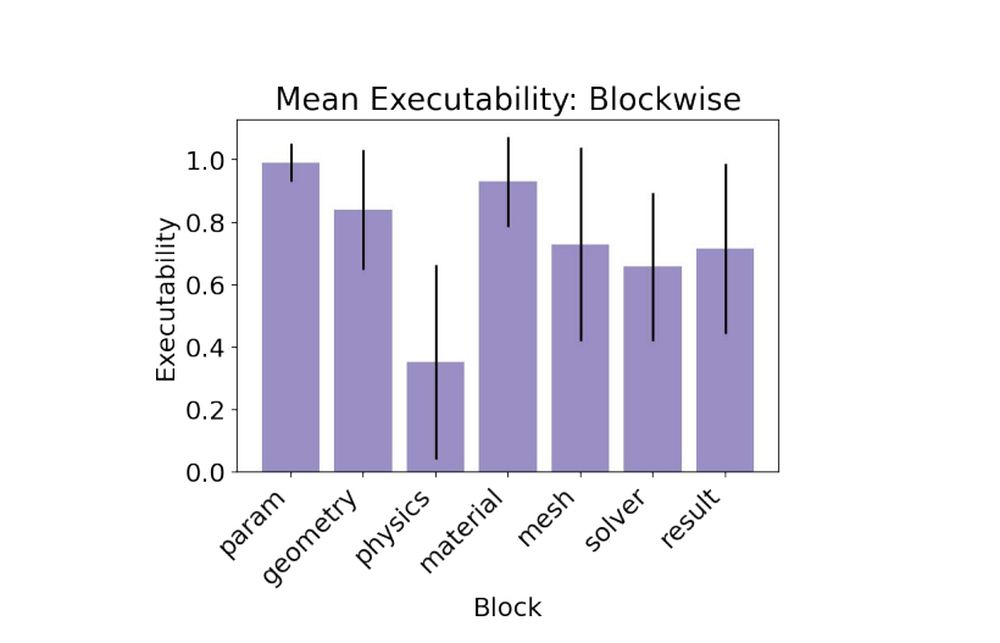

W badaniach wyjściowych modele zamknięte, takie jak Claude 3.5, GPT-4O i Gemini 1.5, przewyższyły modele otwarte. Claude 3.5 poprowadził paczkę, osiągając 79% możliwości wykonywania i zdobywając jedyny ważny cel problemu złota. Otwarte modele walczyły, z niektórymi halucynacyjnymi interfejsami fizyki lub niewłaściwymi aplikacjami. Najtrudniejsza część? . blok fizykigdzie modele musiały zastosować dokładne warunki brzegowe i właściwości fizyki, aby uzyskać wyniki pasujące do prawdy naziemnej.

- Sonet Claude 3.5: 0,79 Wykonalność, 1/15 prawidłowy cel

- GPT-4O: 0,78 Wykonalność, prawidłowy cel 0/15

- Gemini-1.5-Pro: 0,60 Wykonalność, prawidłowy cel 0/15

Kiedy plan nie wystarczy

Benchmark obejmuje dwa typy zadań. W ModeleSpec Zadanie, LLM otrzymuje jedynie specyfikacje techniczne i musi uzasadnić rozwiązanie. W Plan Zadanie, model otrzymuje instrukcje krok po kroku. Co zaskakujące, zadanie planu nie doprowadziło do lepszej wydajności. Modele często nie powiodły się, przyjmując instrukcje zbyt dosłownie i halucynujące nieprawidłowe nazwy API. Dodanie listy ważnych funkcji COMSOL do monit PHYDOC In-Contekst Strategia – poczuła zmniejszenie halucynacji i znacznie lepszą faktyczność interfejsu.

Lekcje dla inżynierów AI

Jedno wielkie wynos: tłumaczenie jest trudniejsze niż planowanie. Nawet gdy model wie, co robić, wyrażanie go w DSL Comsol (język specyficzny dla domeny) jest blokadą dróg. Rozwiązanie zespołu? Zapewnij narzędzia uziemiające, takie jak biblioteki kodów adnotowane i dokumentacja w kontekście, a następnie sparuj to z ustrukturyzowanymi przepływami pracy agencyjnej. Ten przepis zmienił słabą wydajność jednorazową w solidną poprawę wielu zakrętów. W rzeczywistości osiągnęła strategia agenta wieloznacznego 88% zdolności wykonawczejnajwyższy ze wszystkich eksperymentów.

- ModeleSPecs + Agent Multi-Turn: 0,88 Wykonalność, 2/15 prawidłowych celów

- ModeleSpecs + Phydoc: 0,62 Wykonalność, 1/15 prawidłowych celów

Symulacje to sposób, w jaki inżynierowie ściskają czas i ryzyko. Feabench pokazuje, że LLM nie są gotowe do uruchomienia symulacji bez nadzoru, ale zbliżają się do stania się przydatnymi kopiotami. Ma to znaczenie, jeśli chcemy, aby sztuczna inteligencja pomagała w szybkim prototypowaniu, odkryciu naukowym lub projektowaniu strukturalnym. A jeśli AI może nauczyć się modelować świat fizyczny tak precyzyjnie, jak naśladuje język, nie będzie się po prostu porozmawiać – symulować, rozwiązać, a może kiedyś, nawet wymyślić.