Microsoft Corp. ma rozszerzony Linia PHI modeli języków typu open source z wprowadzeniem dwóch nowych algorytmów zaprojektowanych do przetwarzania multimodalnego i wydajności sprzętu: Phi-4-Mini i Phi-4-Multimodal.

Cechy Phi-4-Mini i Phi-4-Multimodal

Phi-4-Mini to model tylko tekst, który zawiera 3,8 miliarda parametrów, umożliwiając jego wydajne działanie na urządzeniach mobilnych. Opiera się na architekturze transformatora wyłącznie dekodera, która analizuje tylko tekst poprzedzający słowo w celu ustalenia jego znaczenia, zwiększając w ten sposób prędkość przetwarzania i zmniejszając wymagania sprzętowe. Ponadto Phi-4-Mini wykorzystuje technikę optymalizacji wydajności znaną jako pogrupowana uwaga zapytania (GQA) w celu zmniejszenia użycia sprzętu związanego z jego mechanizmem uwagi.

Microsoft Phi-4 AI zajmuje się złożoną matematyką z parametrami 14b

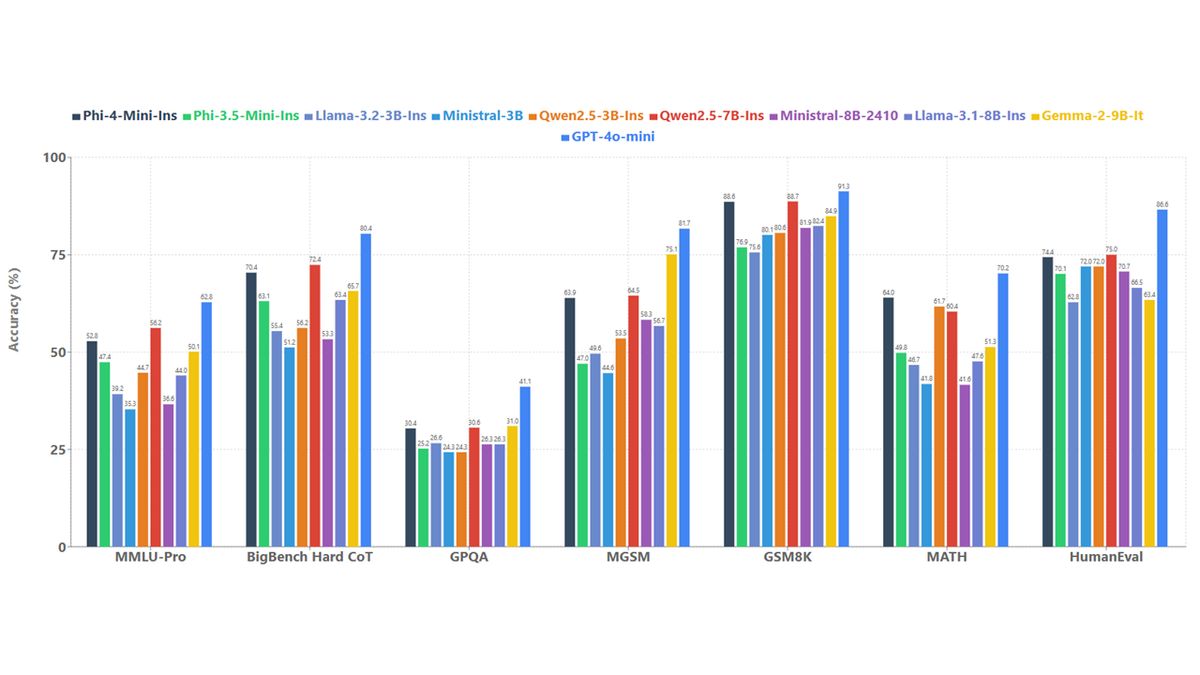

Ten model jest w stanie generować tekst, tłumaczyć dokumenty i wykonywać działania w aplikacjach zewnętrznych. Microsoft twierdzi, że Phi-4-Mini wyróżnia się zadaniami wymagającymi złożonego rozumowania, takich jak obliczenia matematyczne i wyzwania kodowania, osiągając znacznie lepszą dokładność w wewnętrznych testach porównawczych w porównaniu z innymi modelami językowymi o podobnie wielkości.

Drugi model, Phi-4-Multimodal, to ulepszona wersja PHI-4-Mini, która oferuje parametry 5,6 miliarda. Jest w stanie przetwarzać dane, obrazy, audio i wideo. Model ten został przeszkolony przy użyciu nowej techniki zwanej mieszaniną Loras, która optymalizuje możliwości modelu do przetwarzania multimodalnego bez szeroko zakrojonych modyfikacji istniejących wag.

Microsoft przeprowadził testy porównawcze na Phi-4-Multimodal, gdzie uzyskał średni wynik 72 w wizualnym przetwarzaniu danych, po prostu od GPT-4 Openai, który uzyskał 73. Google’s Gemini Flash 2.0 prowadził z wynikiem 74,3. W połączonych zadaniach wizualnych i audio phi-4-multimodalny przewyższył błysk Flash Gemini-2,0 „przez duży margines” i przewyższał internomni, który jest specjalizowany do przetwarzania multimodalnego.

Zarówno Phi-4-Multimodal, jak i Phi-4-Mini są licencjonowane na podstawie licencji MIT i będą udostępniane za pośrednictwem Przytulanie twarzyumożliwiając użycie komercyjne. Programiści mogą uzyskać dostęp do tych modeli za pośrednictwem Azure AI Odlewnia I Katalog Nvidia API Aby dalej zbadać swój potencjał.

Phi-4-multimodal jest specjalnie zaprojektowany w celu ułatwienia interakcji naturalnych i kontekstowych poprzez integrację wielu typów wejściowych z jednym modelem przetwarzania. Obejmuje ulepszenia, takie jak większe słownictwo, możliwości wielojęzyczne i lepsza wydajność obliczeniowa w celu wykonania na urządzeniu.

Phi-4-Mini zapewnia imponującą wydajność w zadaniach tekstowych, w tym możliwości rozumowania i funkcji, umożliwiając skuteczne interakcję z strukturalnym interfejsami programowania. Platforma obsługuje sekwencje do 128 000 tokenów.

Ponadto oba modele przeszły szeroko zakrojone testy bezpieczeństwa i bezpieczeństwa, prowadzone przez wewnętrzny zespół Azure AI Microsoft AI Red (AIRT), który oceniał modele przy użyciu kompleksowych metodologii oceny, które dotyczą obecnych trendów w zakresie bezpieczeństwa cybernetycznego, uczciwości i bezpieczeństwa użytkowników.

Dostosowywanie i łatwość wdrażania są dodatkowymi zaletami tych modeli, ponieważ ich mniejsze rozmiary pozwalają im dostosować się do określonych zadań o stosunkowo niskich wymaganiach obliczeniowych. Przykłady zadań odpowiednich do dopracowania obejmują tłumaczenie mowy i odpowiedź na pytania medyczne.

Aby uzyskać więcej informacji na temat modeli i ich aplikacji, programiści są zachęcani do odniesienia się do Książka kucharska Phi Dostępne w GitHub.

Wyróżniony obraz Obraz Kredyt: Microsoft