Duże modele językowe (LLM) stają się mądrzejsze, ale także uderzają w ścianę: obsługa długich kawałków tekstu jest powolna i kosztowna obliczeniowo. Tradycyjne mechanizmy uwagi – rdzeń tego, jak AI przetwarza i pamięta informacje – zaskakujące do wydajnej skalowania, dzięki czemu modele kosztowne do szkolenia i uruchomienia.

Teraz naukowcy z Deepseek-AI i Peki University Posiadać wprowadzone Podejście zmieniające grę o nazwie Natywnie rzadka uwaga (NSA). Ta nowa metoda obiecuje znacząco uczynić modele AI Szybszy, tańszy i bardziej wydajnywszystko przy jednoczesnym zachowaniu takiego samego poziomu rozumowania jak tradycyjne podejścia.

Dlaczego problem uwagi AI wymaga naprawy

Wyobraź sobie, że czytasz książkę, w której musisz pamiętać o każdym zdaniu przez cały czas – tak właśnie Pełna uwaga Mechanizmy działają w sztucznej inteligencji. Skanują i przechowują informacje w długich sekwencjach, ale wraz ze wzrostem długości kontekstu (myśl tysiące słów), podejście to staje się niezwykle powolne i obliczeniowo ciężkie.

Aby to rozwiązać, naukowcy zbadali Rzadka uwaga– Które selektywnie przetwarza tylko najważniejsze informacje zamiast wszystkiego. Jednak istniejące rzadkie metody mają Główne słabości:

- Trudno je trenowaćczęsto wymagające modeli do nauki z pełną uwagą przed przejściem na rzadkie podejście.

- Nie optymalizują w pełni dla nowoczesnego sprzętuco oznacza teoretyczną poprawę prędkości, nie zawsze przekładają się na rzeczywistą wydajność.

Jak NSA zmienia grę

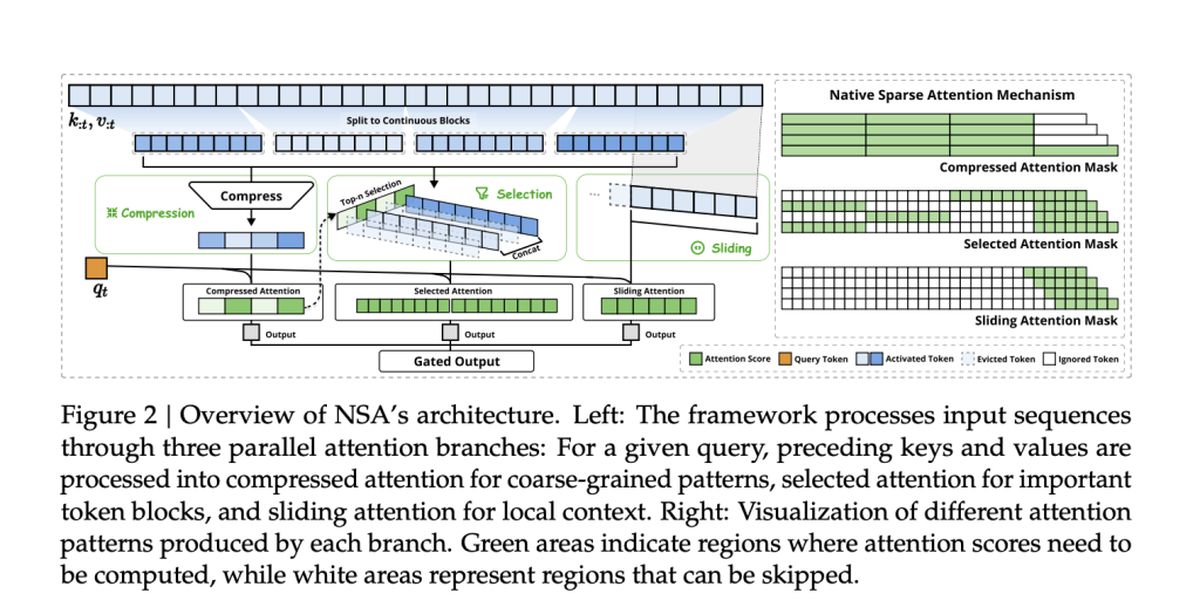

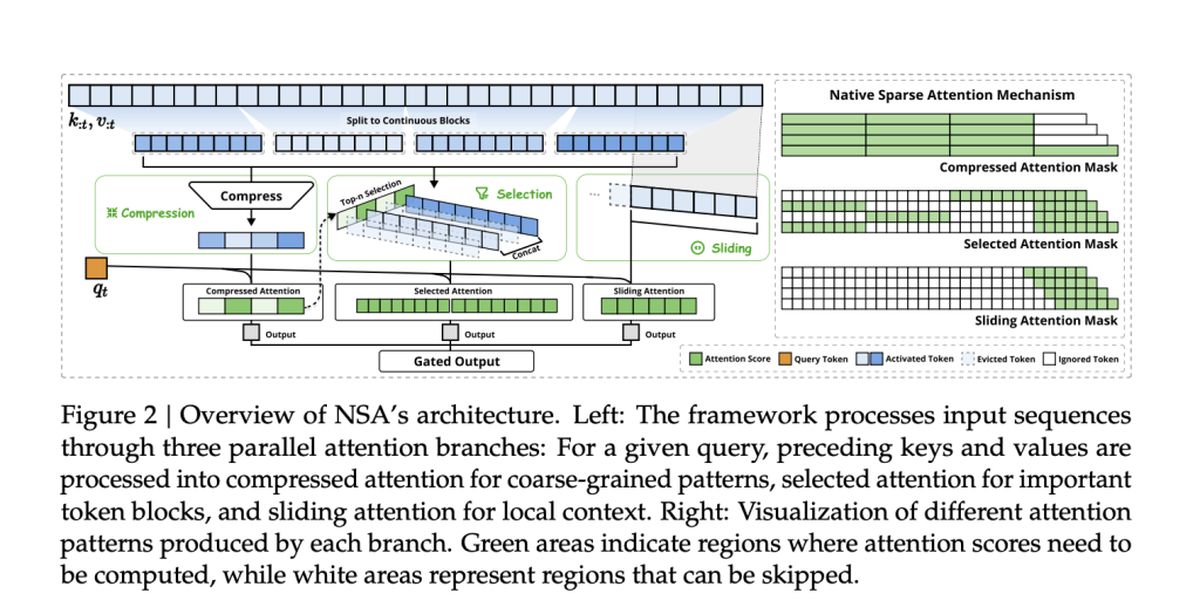

Zespół stojący za NSA, w tym Jingyang Yuan, Huazuo Gao, Damai Dai i ich współpracownicy, przyjął nowe podejście. Ich metoda natywnie integruje rzadkość od samego początkuzamiast stosować go jako refleksję.

NSA to osiąga z Dwie kluczowe innowacje:

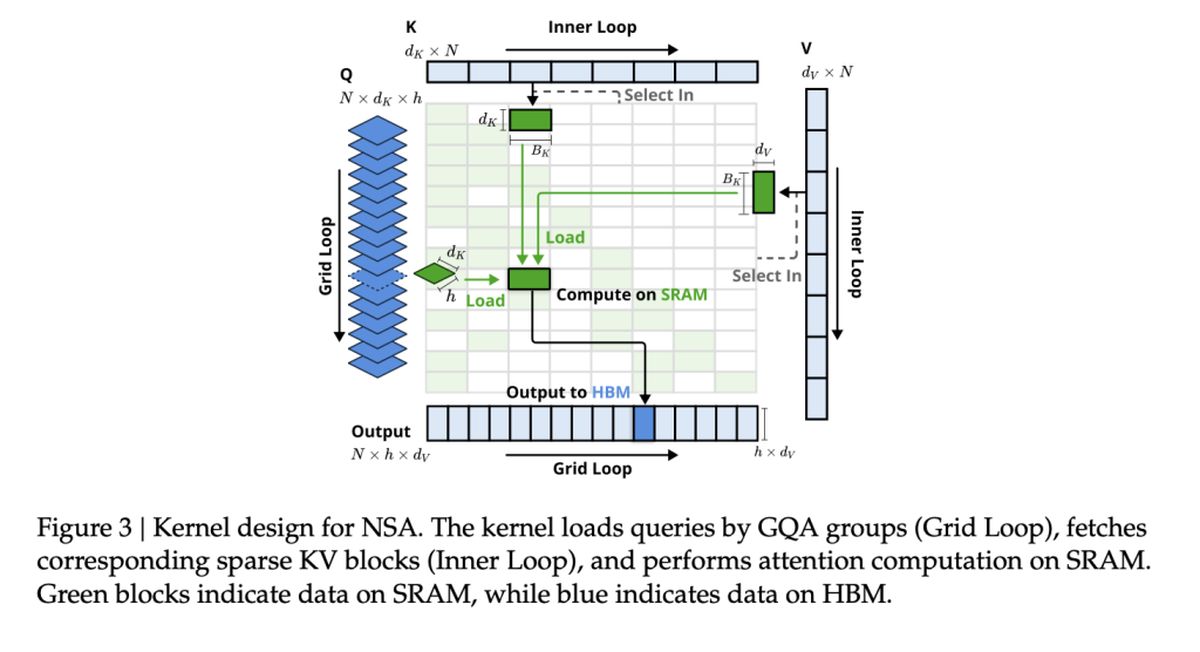

- Wydajność dostosowana do sprzętu: NSA jest zbudowany w celu maksymalizacji wydajności GPU, unikając wąskich gardeł pamięci i zapewniania szybkości w świecie rzeczywistym.

- Kompleksowa szkolenie: W przeciwieństwie do poprzednich rzadkich metod, NSA można w pełni trenować od zera, zmniejszając koszty szkolenia bez utraty dokładności.

Szybkość i dokładność: przewaga NSA

Jak więc NSA układa się z tradycyjnymi modelem pełnej uwagi? Według badania, NSA osiąga do 11 × ulepszeń prędkości Wciąż pasując – lub nawet przewyższając – pełną uwagę na kluczowych testach porównawczych.

Niektóre z największych zwycięstw obejmują:

- Szybsze przetwarzanie: NSA przyspiesza zdolność sztucznej inteligencji do obsługi długich dokumentów, baz kodowych i rozmów z wieloma zwrotami.

- Lepsze rozumowanie: Pomimo „rzadkich” modeli NSA dopasować lub przekraczać Modele pełnej uwagi w zadaniach rozumujących łańcuch.

- Niższe koszty: Zmniejszając obliczenia bez poświęcania wydajności, NSA może sprawić, że zaawansowana sztuczna inteligencja może być bardziej przystępna do szkolenia i wdrażania.

Istniejące rzadkie metody uwagi

Wiele istniejących rzadkich mechanizmów uwagi próbuje zmniejszyć koszty obliczeniowe przez Selektywnie przycinają tokeny Lub Optymalizacja dostępu do pamięci. Często jednak nie mają one problemu w praktycznym wdrożeniu, ponieważ wprowadzają komponenty nie trenujące, albo nie dostosowują się do nowoczesnych architektur GPU.

Na przykład:

- Clusterkv i MagicPig Polegaj na technikach dyskretnych klastrów lub mieszania, które zakłócają przepływ gradientu i utrudnia szkolenie modelu.

- H2O i minferencja Zastosuj rzadkość tylko na określonych etapach wnioskowania, ograniczając poprawę prędkości w pełnym rurociągu.

- Quest and Infllm Użyj metod selekcji blokowej, ale ich ocena oparta na heurystyce często powoduje niższe wskaźniki wycofania.

NSA rozwiązuje te ograniczenia poprzez integrację rzadkości natywnie—Sching Skuteczność zarówno w szkoleniu, jak i wnioskowaniu przy jednoczesnym zachowaniu dokładności modelu. To oznacza Brak przybliżeń post-hoc lub kompromisy między możliwościami prędkości i rozumowania.

Wydajność NSA na temat rzeczywistych zadań

Aby potwierdzić skuteczność NSA, naukowcy przetestowali ją w różnych zadaniach AI, porównując jego wydajność z tradycyjnymi modelami pełnej uwagi i najnowocześniejszymi metodami rzadkiej uwagi. Wyniki podkreślają zdolność NSA do Dopasuj lub przewyższają modele pełnej uwagi, jednocześnie znacznie zmniejszając koszty obliczeniowe.

Ogólna wydajność porównawcza

NSA wykazała Silna dokładność w zakresie wiedzy, rozumowania i kodowania testów porównawczychw tym:

- MMLU i CMMLU: Dopasowanie pełnej uwagi w zadaniach opartych na wiedzy

- GSM8K & Math: Przewyższając pełną uwagę w złożonym rozumowaniu

- Humaneval i MBPP: Dostarczanie wydajności solidnej kodowania

Zrozumienie długiego kontaktu

NSA wyróżnia się w obsłudze sekwencji długotertowych w testach porównawczych Longbench. W zadaniach wymagających głębokiej pamięci kontekstowej NSA utrzymała:

- Wysokie wycofanie zadań odzyskiwania (Igle-in-a-haytack, dokument QA)

- Stabilna dokładność w rozumowaniu wielu hopów (HPQ, 2wiki, Govrpt)

Rzeczywiste wzrosty prędkości

Optymalizacje wyrównane przez sprzęt w NSA prowadzą do:

- 9 × szybsze prędkości wnioskowania Dla sekwencji długości 64K

- 6 × szybszy trening W porównaniu z modelami pełnej uwagi

- Zmniejszone zużycie przepustowości pamięciuczynienie na dużą skalę aplikacji AI bardziej wykonalnych