Sztuczna inteligencja staje się lepsza w zrozumieniu świata w trzech wymiarach, ale nowe badanie sugeruje, że wielu 3D Model Large Language (LLM) mogą w ogóle nie testować możliwości 3D. Zamiast tego oceny te mogą być ofiarą tego, co badacze nazywają problemem „chacie 2D”-gdzie modele AI przeszkolone przede wszystkim na obrazach 2D mogą przewyższyć dedykowane modele 3D po prostu poprzez renderowanie chmur punktowych na obrazy.

Zespół z Shanghai Jiao Tong University, w tym Jiahe Jin, Yanheng He i Mingyan Yang, znalazł w swoich badaniach ”,„Wersja testów porównawczych 3D LLM: czy naprawdę testujemy możliwości 3D? ”, że wiele zadań stosowanych do oceny AI 3D można równie łatwo rozwiązać za pomocą modeli w języku wizji (VLM)-systemy nie wyszkolone przede wszystkim na obrazach i tekstach 2D. Rodzi to kluczowe pytanie: czy obecne punkty odniesienia naprawdę mierzą zrozumienie 3D, czy po prostu testują, jak dobrze AI może przetwarzać renderingi 2D danych 3D?

Cheating 2D: skrót, który odsłania słabe wskaźniki porównawcze

Problem wynika ze sposobu oceniania LLM 3D. Wiele istniejących testów porównawczych polega Pytania i odpowiedzi i zeznaniagdzie AI jest proszeni o opisanie obiektu 3D lub odpowiedzieć na pytania. Zakłada się, że AI wyszkolonej w 3D powinien osiągnąć lepiej niż ten, który rozumie tylko obrazy 2D.

Jednak naukowcy to odkryli VLM, takie jak GPT-4O i QWEN2-VLktóre nie zostały specjalnie zaprojektowane do zadań 3D, mogły często przewyższają najnowocześniejsze modele 3D—Simply, patrząc na obrazy 2D chmur punktowych. Sugeruje to, że te testy w rzeczywistości nie testują, czy AI rozumie struktury 3D, ale raczej Jak dobrze może wywnioskować informacje 3D z płaskich obrazów.

Aby to zademonstrować, zespół się rozwinął VLM3DMetoda, która przekształca chmury 3D w renderowane obrazy przed podaniem ich w VLM. Po przetestowaniu na głównych testach testowych 3D – w tym 3D MM-VET, objaversexl-lvis, scanqa i sqa3d—VLM3D konsekwentnie przewyższał lub dopasował wiodące modele 3D w wielu zadaniach.

Dlaczego niektóre zadania 3D są bardziej wrażliwe niż inne

Podczas gdy VLM wyróżniały się w zadaniach takich jak rozpoznawanie obiektów i podstawowy opis sceny, walczyły o zadania, które wymagały głębszego zrozumienia relacje przestrzenne, okluzje i spójność wielu widoków.

- Proste testy porównawcze obiektów 3D: Wiele zadań rozpoznawania obiektów w testach porównawczych 3D może być Łatwo rozwiązane za pomocą obrazów 2D. Badanie wykazało, że VLM mogą pasować lub przekraczać modele 3D w tych przypadkach, co dowodzi, że wartości porównawcze nie testowały skutecznie zrozumienia 3D.

- Złożone odniesienia sceny: Zadania wymagające AI do zrozumienia pełnych środowisk 3D, takich jak Pytania i odpowiedzi na poziomie scenyW nawigacjaI Rozumowanie sytuacyjnebyły znacznie trudniejsze do oszukiwania VLM. Tutaj 3D LLM konsekwentnie działało lepiej, pokazując, że zadania te opierają się na prawdziwym rozumowaniu przestrzennym 3D.

To oznacza Nie wszystkie badania 3D są wadliwe– ale wiele z nich nie rozróżnia między prawdziwe możliwości 3D i sztuczki wnioskowania 2D.

Kiedy modele 2D utkną

Jedna z największych słabości VLM w zadaniach 3D pochodzi Wybór punktu widzenia– Fakt, że pojedynczy obraz 2D przechwytuje tylko część sceny 3D.

Badacze przetestowali Trzy różne podejścia do renderowania Aby ocenić, ile to wpływa na wydajność:

- Pojedynczy widok: Najprostsze podejście, w którym obiekt lub scena jest renderowana z ustalonej perspektywy. VLMS osiągnęły najlepiej tutajponieważ mogą wyodrębnić wystarczającą ilość informacji z jednego obrazu.

- Multi-View: Zdjęcia zostały wykonane z Cztery różne kątydając modele AI więcej kontekstu. Co zaskakujące, VLM nie poprawił się znacząco W porównaniu z modelami jednoznacznymi, sugerując, że mają trudności z połączeniem wielu perspektyw w zunifikowane zrozumienie 3D.

- Widok Oracle: AI otrzymano Najlepszy możliwy punkt widzenia za odpowiedź na każde pytanie. Tutaj VLM działały znacznie lepiejale nadal nie było dedykowanych LLM 3D, pokazując, że nawet jeśli otrzymują idealne obrazy, brakuje im prawdziwych umiejętności rozumowania 3D.

To wzmacnia pomysł VLM nie „rozumie” 3D– Po prostu dobrze sobie radzą, gdy otrzymają odpowiednie widoki 2D.

Co musi się zmienić

Aby naprawdę ocenić modele AI 3D, badanie proponuje Cztery kluczowe zasady Do projektowania lepszych testów porównawczych:

- Bardziej złożone dane 3D: Zamiast używać prostych chmur punktów obiektowych, powinny uwzględniać testy porównawcze szczegółowe i realistyczne sceny 3D ze złożonością strukturalną.

- Zadania wymagające prawdziwego rozumowania 3D: Zamiast tylko rozpoznawania obiektów, AI należy testować na wymaganych zadaniach Zrozumienie przestrzennetakie jak przewidywanie ukrytych powierzchni lub rozumowanie o interakcjach obiektów.

- Wyzwania związane z kontekstem: Pytania powinny być zaprojektowane tak, aby skupić się Unikalne właściwości 3Dupewniając się, że nie można na nich odpowiedzieć za pomocą jednego obrazu 2D.

- Lepsze wskaźniki oceny: Obecne testy testy często polegają Wyniki podobieństwa tekstuktóre nie uchwycają Prawdziwe zrozumienie 3D. Zamiast tego modele AI należy oceniać na podstawie ich zdolności wywnioskować głębokość, struktura i relacje obiektowe w trójwymiarowej przestrzeni.

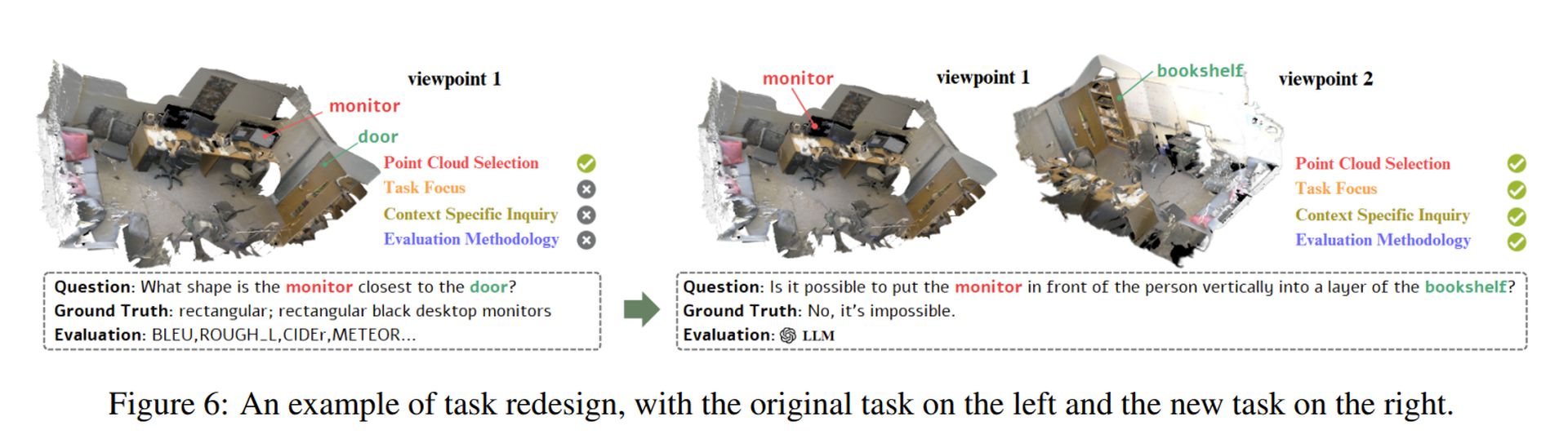

Naukowcy wykazali, w jaki sposób te zasady mogą być stosowane przez przeprojektowanie wadliwego zadania (patrz powyższy obraz). Ich podejście zapewnia, że modele AI faktycznie muszą Przetwarzaj struktury 3D zamiast polegać na skrótach 2D.

Wyróżniony obraz obrazu: Sebastian Svenson/Unsplash