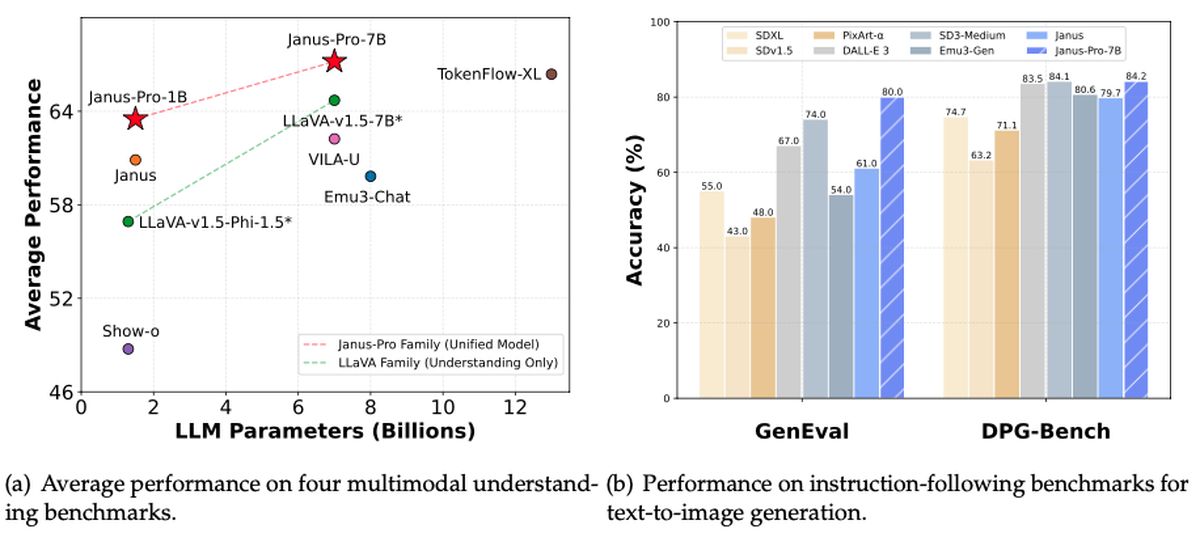

DeepSeek zaprezentował kolejny ważny wkład w krajobraz sztucznej inteligencji typu open source. Tym razem jest to Janus-Pro-7B: wielomodalny potężny moduł zdolny zarówno do rozumienia, jak i generowania obrazów. Według Rowana Cheunganowy model nie tylko przyćmiewa DALL-E 3 i Stable Diffusion OpenAI w testach porównawczych takich jak GenEval i DPG-Bench, ale także wykazuje tego samego ducha „bezpłatnej dostępności”, dzięki któremu wcześniejszy model R1 DeepSeek stał się wirusową sensacją. Tymczasem inwestorzy starają się zrozumieć gwałtowny wzrost liczby przełomowych rozwiązań w zakresie sztucznej inteligencji, m.in Akcje NVIDIA spadły w południe o ponad 17%..

Czy Janus-Pro-7B może być kolejnym wielkim przełomem na i tak już burzliwym rynku technologicznym?

Co to jest DeepSeek Janus-Pro-7B?

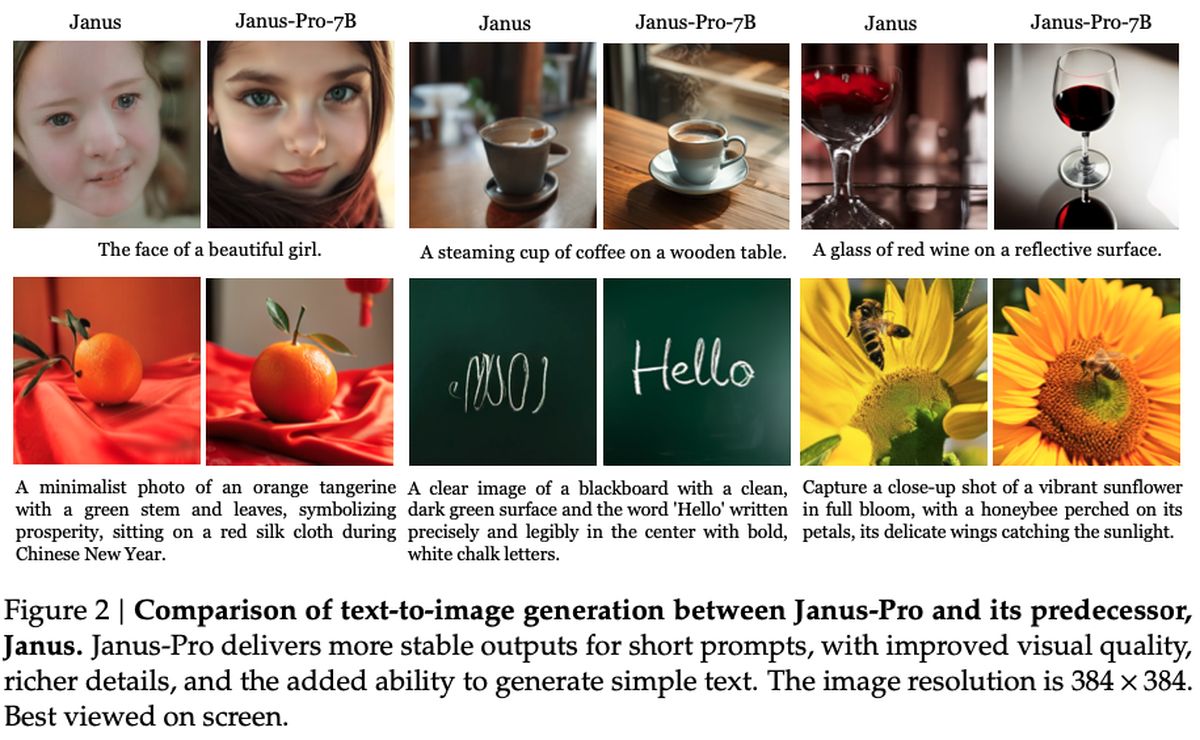

Pod maską Janus-Pro-7B stara się wypełnić lukę pomiędzy potężnym przetwarzaniem obrazu a szybkim generowaniem tekstu. Wykorzystując nowatorskie podejście do odsprzęgania z kodera SigLIP-L, system może szybko przeanalizować obraz o rozdzielczości 384 x 384 przed przejściem do trybu kreatywnego wyjścia. Dorównuje, a nawet przewyższa wiele specjalistycznych modeli dostępnych w kosmosie – osiągnięcie szczególnie uderzające, biorąc pod uwagę, że pozostaje niezwykle łatwy w dostosowywaniu i rozbudowie.

Analitycy wskazują na konsekwentną filozofię DeepSeek: utrzymywanie oprogramowania typu open source, stawianie na prywatność na pierwszym miejscu i podcinanie pozycji rywali korzystających z subskrypcji. Janus-Pro-7B wydaje się działać na wszystkich trzech frontach, ustanawiając wysokie oceny w zakresie wydajności, zachowując jednocześnie dostępność, która przyciągnęła fanów do możliwości trybu offline DeepSeek-R1.

Mówiąc czysto rzeczowo, Janus-Pro-7B jest objęty licencją zezwalającą Ramy MITz dodatkowymi wytycznymi dotyczącymi użytkowania od DeepSeek. Model integruje się z kolejnymi projektami za pośrednictwem repozytorium GitHub i według doniesień wykorzystuje jedynie 16-krotne próbkowanie w procesie generowania obrazów. Obecne wskaźniki sugerują, że pojawienie się Janus-Pro-7B może zapoczątkować nową konkurencję wśród twórców sztucznej inteligencji, choć dopiero czas pokaże, jak ta najnowsza bezpłatna oferta wpłynie na strefę sztucznej inteligencji.

Jak łatwo i bezpłatnie skonfigurować DeepSeek-R1 (online i lokalnie)?

Jak to działa?

Jak szczegółowo opisano w artykuł badawczy opublikowany przez DeepSeek, model wykorzystuje koder SigLIP-Large-Patch16-384, który dzieli każdy obraz na 16 × 16 fragmentów w rozdzielczości 384 × 384. Takie podejście pozwala zachować drobne szczegóły, pomagając systemowi w dokładniejszej interpretacji obrazów. Po stronie generacji Janus-Pro wykorzystuje słownik zawierający 16 384 tokenów do reprezentowania obrazów w 16-krotnie zmniejszonej skali, umożliwiając wydajne rekonstrukcje, które pod względem jakości mogą konkurować – jeśli nie przewyższać – tradycyjne modele dyfuzyjne.

Dwa kluczowe adaptery MLP (Multi-Layer Perceptron) łączą te komponenty rozumienia i generowania, zapewniając płynny przepływ danych między dwoma zadaniami. Podczas szkolenia model widzi mieszankę danych obrazu i tekstu, dzięki czemu może nauczyć się interpretować sceny wizualne i tworzyć własne obrazy. Sesje trwają zwykle od 7 do 14 dni na dużych klastrach procesorów graficznych (zarówno w przypadku wersji parametrów 1,5B, jak i 7B), a wydajność jest testowana w testach porównawczych, takich jak GQA (do rozumienia wizualnego) i VisualGen (do tworzenia obrazu). Rezultatem jest wszechstronna platforma, która wyróżnia się zadaniami multimodalnymi dzięki wyspecjalizowanej, ale spójnej architekturze.

Jak korzystać z DeepSeek Janus-Pro-7B?

Rozpoczęcie pracy z Janus-Pro-7B jest tak proste, jak przejście do oficjalnego repozytorium GitHub, sklonowanie lub pobranie kodu i zainstalowanie niezbędnych zależności. Repozytorium zawiera obszerny plik README, który przeprowadzi Cię przez proces konfigurowania środowiska Python, pobierania wag modeli i uruchamiania przykładowych skryptów. W zależności od sprzętu możesz wybrać tryb wyłącznie procesora lub wykorzystać akcelerację procesora graficznego w celu uzyskania większej wydajności. Tak czy inaczej, proces instalacji pozostaje prosty dzięki dobrze udokumentowanym wymaganiom wstępnym i instrukcjom krok po kroku.

Kiedy już wszystko będzie działać, możesz wprowadzić monity o wygenerowanie tekstu lub zapewnić obraz wejściowy dla unikalnych możliwości multimodalnych modelu. Przykładowe notatniki w repozytorium pokazują, jak generować kreatywne wyniki, stosować zaawansowane transformacje obrazów lub eksplorować scenariusze „wizualnych pytań i odpowiedzi”. Bardziej zaawansowanym użytkownikom modułowa konstrukcja repozytorium oznacza, że można modyfikować podstawowe warstwy, podłączać własne zbiory danych, a nawet łączyć model z innymi wersjami DeepSeek, takimi jak R1.