Generowanie tekstu na wideo nie jest już tym samym, co jeszcze kilka lat temu. Przekształciliśmy go w narzędzie o iście futurystycznej funkcjonalności. Użytkownicy tworzą treści na osobiste strony, wpływowi wykorzystują je do autopromocji, a firmy wykorzystują je do wszystkiego, od materiałów reklamowych i edukacyjnych po wirtualne szkolenia i produkcję filmów. Większość systemów zamiany tekstu na wideo zbudowana jest w oparciu o architekturę transformatorów dyfuzyjnych, które stanowią najnowocześniejsze rozwiązanie w świecie generacji wideo. Technologia ta stanowi podstawę usług takich jak Luma i Kling. Jednak status ten ugruntował się dopiero w 2024 r., kiedy na rynku przyjęto pierwsze transformatory dyfuzyjne do zastosowań wideo.

Nadszedł punkt zwrotny Wydanie OpenAI z SORAprezentując niezwykle realistyczne ujęcia, które były prawie nie do odróżnienia od prawdziwego życia. OpenAI pokazało, że ich transformator dyfuzyjny może z powodzeniem generować treści wideo. Posunięcie to potwierdziło potencjał technologii i zapoczątkowało trend w całej branży: obecnie około 90% obecnych modeli opiera się na transformatorach dyfuzyjnych.

Dyfuzja to fascynujący proces, który zasługuje na dokładniejsze zbadanie. Rozumiemy, jak działa dyfuzja, wyzwania, przed którymi stoi technologia transformatorowa w tym procesie i dlaczego odgrywa ona tak znaczącą rolę w generowaniu tekstu na wideo.

Na czym polega proces dyfuzji GenAI?

U podstaw generowania tekstu na wideo i tekstu na obraz leży proces rozpowszechniania. Zainspirowane zjawiskiem fizycznym, w którym substancje stopniowo się mieszają — niczym atrament dyfuzyjny w wodzie — modele dyfuzji w uczeniu maszynowym obejmują proces dwuetapowy: dodawanie szumu do danych, a następnie uczenie się go usuwać.

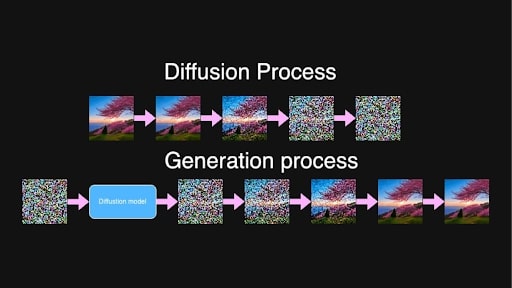

Podczas treningu model wykonuje obrazy lub sekwencje klatek wideo i stopniowo dodaje szum w kilku etapach, aż oryginalna treść stanie się nie do odróżnienia. Zasadniczo zamienia go w czysty szum.

Procesy rozpowszechniania i generowania „Pięknego, dmuchającego drzewa sakura umieszczonego na wzgórzu podczas wschodu słońca”.

Procesy rozpowszechniania i generowania „Pięknego, dmuchającego drzewa sakura umieszczonego na wzgórzu podczas wschodu słońca”.

Podczas generowania nowej treści proces działa w odwrotnej kolejności. Model jest szkolony do przewidywania i usuwania szumu stopniowo, koncentrując się na losowym pośrednim kroku szumu pomiędzy dwoma punktami t i t+1. Dzięki długiemu procesowi uczenia model zaobserwował wszystkie etapy przejścia od czystego szumu do prawie czystych obrazów i teraz ma całkiem niezłą zdolność identyfikowania i redukowania szumu na zasadniczo dowolnym poziomie.

Z przypadkowego, czystego szumu model, kierując się tekstem wejściowym, iteracyjnie tworzy klatki wideo, które są spójne i zgodne z opisem tekstowym. Rezultatem tego bardzo stopniowego procesu jest wysokiej jakości, szczegółowa treść wideo.

Dzięki dyfuzji utajonej jest to możliwe obliczeniowo. Zamiast pracować bezpośrednio z obrazami lub filmami o wysokiej rozdzielczości, dane są kompresowane w ukrytej przestrzeni przez koder.

Ma to na celu (znacznie) zmniejszenie ilości danych, które model musi przetworzyć, przyspieszając generowanie bez utraty jakości. Gdy proces rozpowszechniania udoskonali ukryte reprezentacje, dekoder przekształca je z powrotem w obrazy lub filmy w pełnej rozdzielczości.

Problem z generacją wideo

W przeciwieństwie do pojedynczego obrazu, wideo wymaga, aby obiekty i postacie pozostawały stabilne przez cały czas, co zapobiega nieoczekiwanym przesunięciom lub zmianom wyglądu. Wszyscy widzieliśmy cuda, do jakich zdolna jest generatywna sztuczna inteligencja, ale sporadyczny brak ramienia lub nieodróżnialny wyraz twarzy mieszczą się w normie. Jednak w filmie stawka jest wyższa; Konsystencja ma ogromne znaczenie dla wrażenia płynności.

Jeśli więc postać pojawia się w pierwszej klatce w określonym stroju, strój ten musi wyglądać identycznie w każdej kolejnej klatce. Jakakolwiek zmiana wyglądu postaci lub jakakolwiek „morfizacja” obiektów w tle przerywa ciągłość i sprawia, że wideo wydaje się nienaturalne, a nawet niesamowite.

Zdjęcie udostępnione przez autora

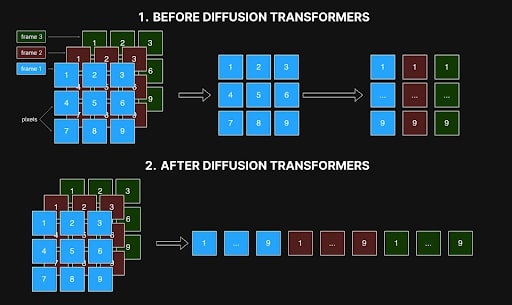

Wczesne metody opierały się na generowaniu wideo poprzez indywidualne przetwarzanie klatek, przy czym każdy piksel w jednej klatce odnosił się tylko do odpowiadającego mu piksela w innych. Jednak podejście klatka po klatce często powodowało niespójności, ponieważ nie pozwalało uchwycić relacji przestrzennych i czasowych między klatkami, które są niezbędne do płynnych przejść i realistycznego ruchu. Artefakty, takie jak zmieniające się kolory, zmieniające się kształty lub źle wyrównane elementy, są wynikiem braku spójności i pogarszają ogólną jakość wideo.

Zdjęcie udostępnione przez autora

Zdjęcie udostępnione przez autora

Największą przeszkodą w rozwiązaniu tego problemu było zapotrzebowanie na moc obliczeniową i koszt. W przypadku 10-sekundowego wideo przy 10 klatkach na sekundę wygenerowanie 100 klatek wykładniczo zwiększa złożoność. Utworzenie tych 100 klatek jest około 10 000 razy bardziej złożone niż wygenerowanie pojedynczej klatki ze względu na potrzebę precyzyjnej spójności między klatkami. Zadanie to wymaga 10 000 razy więcej pamięci, czasu przetwarzania i zasobów obliczeniowych, często przekraczając praktyczne granice. Jak możesz sobie wyobrazić, luksus eksperymentowania z tym procesem był dostępny dla nielicznych wybranych w branży.

To właśnie sprawiło, że wydanie SORA przez OpenAI było tak znaczące: pokazało, że transformatory dyfuzyjne rzeczywiście mogą obsłużyć generację wideo pomimo ogromnej złożoności zadania.

Jak transformatory dyfuzyjne rozwiązały problem spójności w generowaniu wideo

Pojawienie się transformatorów dyfuzyjnych rozwiązało kilka problemów: umożliwiły one generowanie filmów o dowolnej rozdzielczości i długości, przy jednoczesnym osiągnięciu wysokiej spójności wewnętrznej. Dzieje się tak głównie dlatego, że potrafią pracować z długimi sekwencjami, o ile mieszczą się w pamięci, oraz dzięki mechanizmowi samouważności.

W sztucznej inteligencji samouwaga to mechanizm obliczający wagi uwagi pomiędzy elementami w sekwencji, określając, w jakim stopniu każdy element powinien być pod wpływem innych. Umożliwia to każdemu elementowi sekwencji jednoczesne uwzględnienie wszystkich pozostałych elementów i umożliwia modelom skupienie się na odpowiednich częściach danych wejściowych podczas generowania danych wyjściowych, wychwytując zależności zarówno w przestrzeni, jak i w czasie.

W przypadku generowania wideo oznacza to, że każdy piksel w każdej klatce może odnosić się do każdego innego piksela we wszystkich klatkach. To wzajemne powiązanie zapewnia spójność obiektów i postaci w całym filmie, od początku do końca. Jeśli postać pojawia się w jednej klatce, samouważność pomaga zapobiec zmianom i zachować wygląd tej postaci we wszystkich kolejnych klatkach.

Wcześniej modele obejmowały formę samouważności w sieci splotowej, ale ta struktura ograniczała ich zdolność do osiągnięcia tej samej spójności i spójności, która jest obecnie możliwa w przypadku transformatorów dyfuzyjnych.

Jednak przy jednoczesnej uwadze czasoprzestrzennej w transformatorach dyfuzyjnych architektura może ładować dane z różnych ramek jednocześnie i analizować je jako ujednoliconą sekwencję. Jak pokazano na poniższym obrazku, poprzednie metody przetwarzały interakcje w każdej klatce i łączyły każdy piksel jedynie z odpowiadającą mu pozycją w innych klatkach (patrz rysunek 1). Ten ograniczony widok utrudniał im uchwycenie relacji przestrzennych i czasowych niezbędnych do płynnego i realistycznego ruchu. Teraz w przypadku transformatorów dyfuzyjnych wszystko jest przetwarzane jednocześnie (rysunek 2).

Oddziaływanie czasoprzestrzenne w sieciach dyfuzyjnych przed i za transformatorami. Zdjęcie udostępnione przez autora

Oddziaływanie czasoprzestrzenne w sieciach dyfuzyjnych przed i za transformatorami. Zdjęcie udostępnione przez autora

To holistyczne przetwarzanie pozwala zachować stabilne szczegóły we wszystkich klatkach, zapewniając, że sceny nie zmienią się nieoczekiwanie i nie zamienią się w niespójny bałagan produktu końcowego. Transformatory dyfuzyjne mogą również obsługiwać sekwencje o dowolnej długości i rozdzielczości, pod warunkiem, że mieszczą się w pamięci. Dzięki temu postępowi możliwe jest generowanie dłuższych filmów bez utraty spójności i jakości, co pozwala sprostać wyzwaniom, którym nie udało się przezwyciężyć poprzednich metod opartych na splocie.

Pojawienie się transformatorów dyfuzyjnych zmieniło sposób generowania tekstu na wideo. Umożliwiło to produkcję wysokiej jakości, spójnych filmów o dowolnej długości i rozdzielczości. Samouważność w transformatorach jest kluczowym elementem w stawianiu czoła wyzwaniom, takim jak utrzymanie spójności ramy i obsługa złożonych relacji przestrzennych i czasowych. Wydanie SORA przez OpenAI udowodniło tę zdolność, ustanawiając nowy standard w branży: obecnie około 90% zaawansowanych systemów przetwarzania tekstu na wideo opiera się na transformatorach dyfuzyjnych, a główni gracze, tacy jak Luma, Clink i Runway Gen-3, są wiodącymi rynek.

Pomimo tych zapierających dech w piersiach postępów, transformatory dyfuzyjne w dalszym ciągu pochłaniają bardzo dużo zasobów, wymagając prawie 10 000 razy więcej zasobów niż wygenerowanie pojedynczego obrazu, co sprawia, że szkolenie wysokiej jakości modeli jest w dalszym ciągu bardzo kosztownym przedsięwzięciem. Niemniej jednak społeczność open source podjęła znaczące kroki, aby uczynić tę technologię bardziej dostępną. Projekty takie jak Open-SORA i Open-SORA-Plan, a także inne inicjatywy, takie jak Mira Video Generation, Cog i Cog-2, otworzyły przed programistami i badaczami nowe możliwości eksperymentowania i wprowadzania innowacji. Te projekty open source, wspierane przez firmy i instytucje akademickie, dają nadzieję na ciągły postęp i większą dostępność w zakresie generowania wideo, z korzyścią nie tylko dla dużych korporacji, ale także niezależnych twórców i entuzjastów chcących eksperymentować. To, podobnie jak inne działania podejmowane przez społeczność, otwiera przyszłość, w której generowanie wideo jest zdemokratyzowane, dzięki czemu ta zaawansowana technologia może zostać odkryta przez większą liczbę twórców.