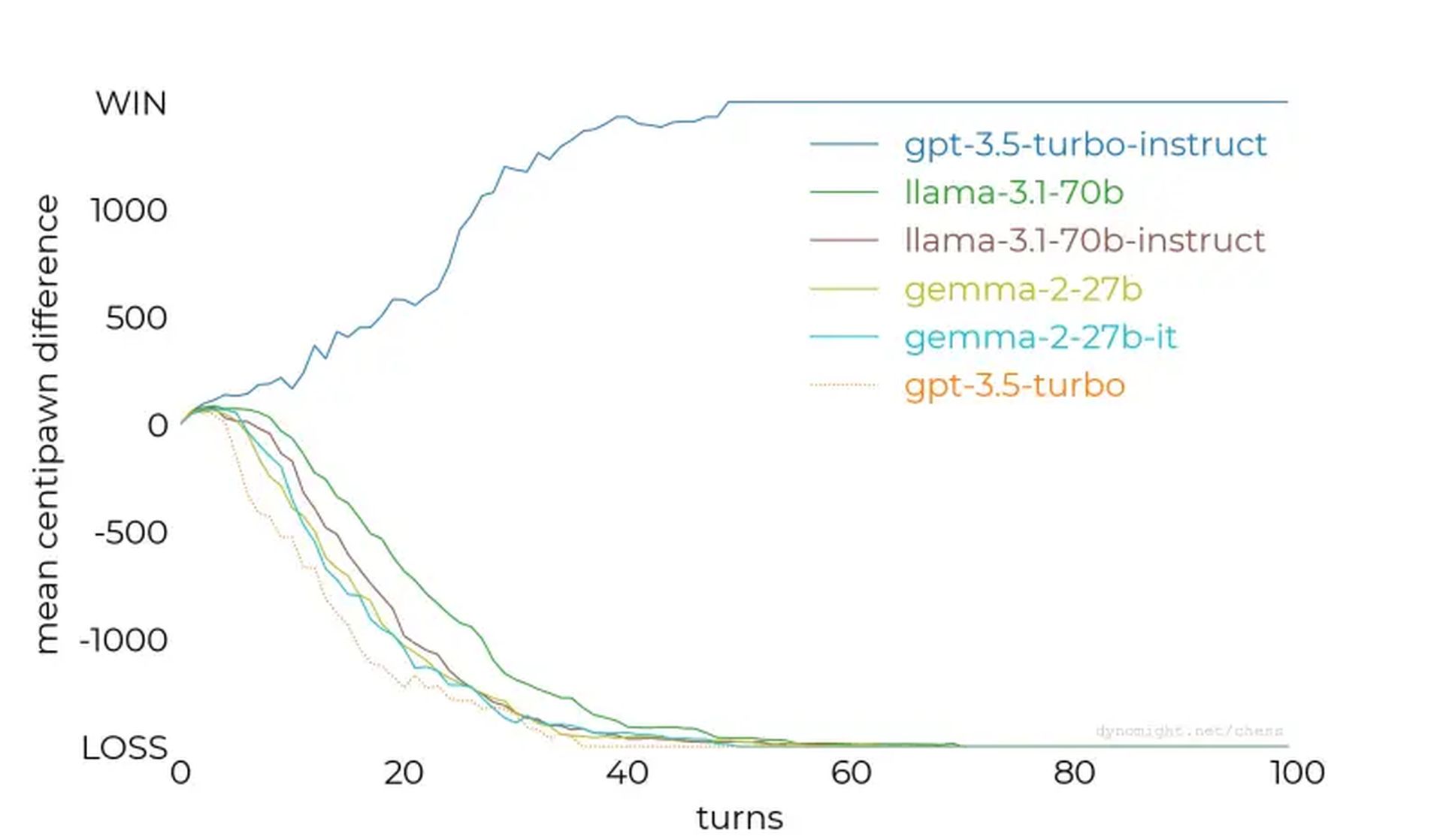

- Nie wszystkie LLM są równe: GPT-3.5-turbo-instruct wyróżnia się jako najpotężniejszy testowany model szachowy.

- Dostrojenie ma kluczowe znaczenie: Dostrajanie instrukcji i ukierunkowana ekspozycja zestawu danych radykalnie zwiększają wydajność w określonych domenach.

- Szachy jako punkt odniesienia: Eksperyment podkreśla, że szachy są cennym punktem odniesienia przy ocenie możliwości LLM i udoskonalaniu systemów sztucznej inteligencji.

Czy modele językowe AI mogą grać w szachy? To pytanie zapoczątkowało niedawne badanie dotyczące tego, jak dobrze duże modele językowe (LLM) radzą sobie z zadaniami szachowymi, ujawniając nieoczekiwane spostrzeżenia na temat ich mocnych i słabych stron oraz metodologii treningu.

Podczas gdy niektóre modele nie radziły sobie nawet z najprostszymi silnikami szachowymi, inne – jak GPT-3.5-turbo-instruct OpenAI – wykazały zaskakujący potencjał, wskazując na intrygujące implikacje dla rozwoju sztucznej inteligencji.

Testowanie LLM przeciwko silnikom szachowym

Naukowcy przetestowali różne LLM, prosząc ich, aby grali w szachy jako arcymistrzowie, podając stany gry w notacji algebraicznej. Początkowe emocje skupiały się na tym, czy LLM, przeszkoleni na rozległych korpusach tekstowych, mogą wykorzystać wbudowaną wiedzę szachową do skutecznego przewidywania ruchów.

Jednak wyniki to pokazały nie wszystkie LLM są sobie równe.

The badanie zaczęło się od mniejszych modeli, takich jak lama-3.2-3bktóry ma 3 miliardy parametrów. Po 50 grach przeciwko Stockfishowi na najniższym poziomie trudności, model przegrywał każdy mecz, nie chroniąc swoich pionków ani nie utrzymując korzystnej pozycji na szachownicy.

Testy rozszerzyły się na większe modele, takie jak lama-3.1-70b i jego wariant dostosowany do instrukcji, ale one również miały problemy, wykazując jedynie niewielką poprawę. Inne modele, w tym Qwen-2,5-72b I polecenie-r-v01kontynuował ten trend, ujawniając ogólną niezdolność do zrozumienia nawet podstawowych strategii szachowych.

Nieoczekiwanym zwycięzcą okazał się GPT-3.5-turbo-instruct

Nadszedł punkt zwrotny GPT-3.5-instrukcja turboktóry wyróżniał się w walce ze Sztokfiszem — nawet przy podwyższonym poziomie trudności silnika. W przeciwieństwie do odpowiedników zorientowanych na czat, takich jak gpt-3.5-turbo I gpt-4omodel dostrojony do instrukcji konsekwentnie generował zwycięskie ruchy.

Dlaczego niektóre modele wyróżniają się, a inne ponoszą porażkę?

Kluczowe wnioski z badania dostarczyły cennych informacji:

- Dostrojenie instrukcji ma znaczenie: Modele takie jak GPT-3.5-turbo-instruct skorzystały na dostrajaniu informacji zwrotnych od człowieka, co poprawiło ich zdolność do przetwarzania ustrukturyzowanych zadań, takich jak szachy.

- Ekspozycja zbioru danych: Istnieją spekulacje, że modele instruujące mogły mieć kontakt z bogatszym zbiorem danych dotyczących partii szachowych, co zapewniło im lepsze rozumowanie strategiczne.

- Wyzwania związane z tokenizacją: Drobne niuanse, takie jak nieprawidłowe spacje w podpowiedziach, zakłócały działanie, podkreślając wrażliwość LLM na formatowanie danych wejściowych.

- Konkurujące dane wpływają na: Szkolenie LLM na różnych zbiorach danych może osłabić ich zdolność do wyróżniania się w wyspecjalizowanych zadaniach, takich jak szachy, chyba że zostanie to zrównoważone ukierunkowanym dostrojeniem.

W miarę ciągłego doskonalenia sztucznej inteligencji wnioski te pozwolą opracować strategie poprawy wydajności modeli w różnych dyscyplinach. Niezależnie od tego, czy chodzi o szachy, rozumienie języka naturalnego, czy inne skomplikowane zadania, zrozumienie, jak trenować i dostrajać sztuczną inteligencję, jest niezbędne do uwolnienia jej pełnego potencjału.

Autor wyróżnionego obrazu: Piotra Makowskiego/Usuń rozpryski