OpenAI, firma stojąca za ChatGPT, zwiększa wysiłki w celu zapewnienia niezawodnej i opłacalnej mocy obliczeniowej dla swoich modeli AI. Opracowując niestandardowe układy krzemowe, OpenAI ma na celu zmniejszenie zależności od zewnętrznych dostawców, takich jak NVIDIA, której procesory graficzne dominują na rynku chipów AI. Według Reutera OpenAI nawiązał współpracę z Broadcom i zabezpieczył moce produkcyjne z Taiwan Semiconductor Manufacturing Company (TSMC), włączając jednocześnie chipy AMD do swojej konfiguracji Microsoft Azure.

OpenAI do tworzenia niestandardowych chipów AI z Broadcom i TSMC

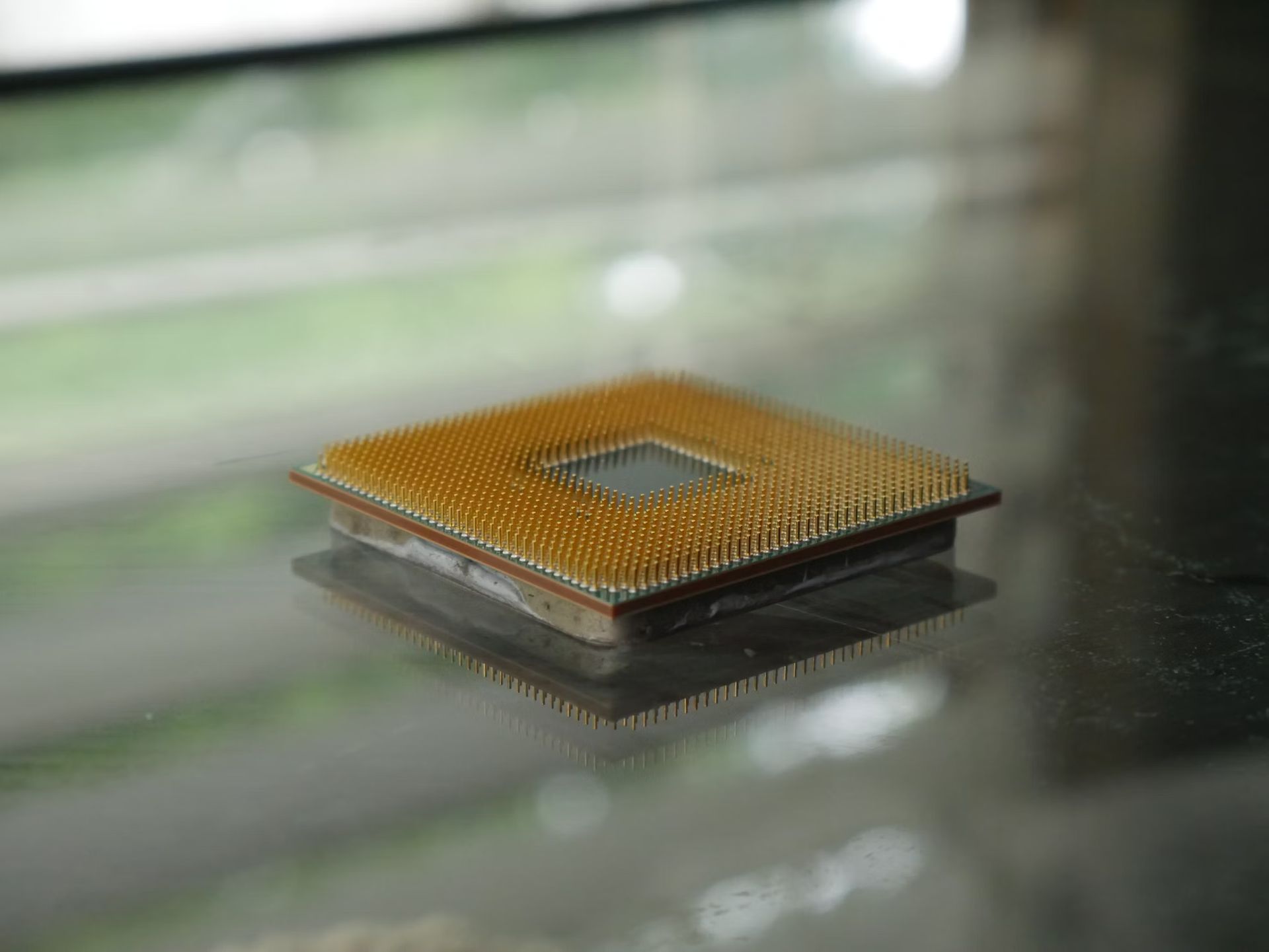

Podróż OpenAI w kierunku opracowania własnych chipów AI rozpoczęła się od zebrania zespołu składającego się z około 20 osób, w tym najlepszych inżynierów, którzy wcześniej pracowali nad jednostkami przetwarzania Tensor (TPU) firmy Google. Ten wewnętrzny zespół ds. chipów, kierowany przez doświadczonych inżynierów, takich jak Thomas Norrie i Richard Ho, ściśle współpracuje z firmą Broadcom przy projektowaniu i produkcji niestandardowych układów krzemowych, które będą skupiać się na obciążeniach wnioskowania. Oczekuje się, że chipy będą produkowane w TSMC, największej na świecie odlewni półprzewodników, począwszy od 2026 roku.

Cel stojący za opracowaniem własnego krzemu jest dwojaki: zapewnienie stabilnych dostaw chipów o wysokiej wydajności i zarządzanie rosnącymi kosztami związanymi z obciążeniami AI. Chociaż zapotrzebowanie na chipy szkoleniowe jest obecnie wyższe, eksperci branżowi przewidują, że zapotrzebowanie na chipy wnioskowujące przewyższy chipy szkoleniowe, w miarę jak coraz więcej aplikacji AI osiągnie etap wdrożenia. Doświadczenie firmy Broadcom w pomaganiu w dopracowywaniu projektów chipów do masowej produkcji i dostarczaniu komponentów optymalizujących przepływ danych sprawia, że jest to idealny partner w tym ambitnym projekcie.

OpenAI rozważało wcześniej budowę własnych fabryk chipów, ale ostatecznie zdecydowało się porzucić te plany ze względu na ogromne koszty i wymagany czas. Zamiast tego OpenAI koncentruje się na projektowaniu niestandardowych chipów, opierając się jednocześnie na TSMC w zakresie produkcji.

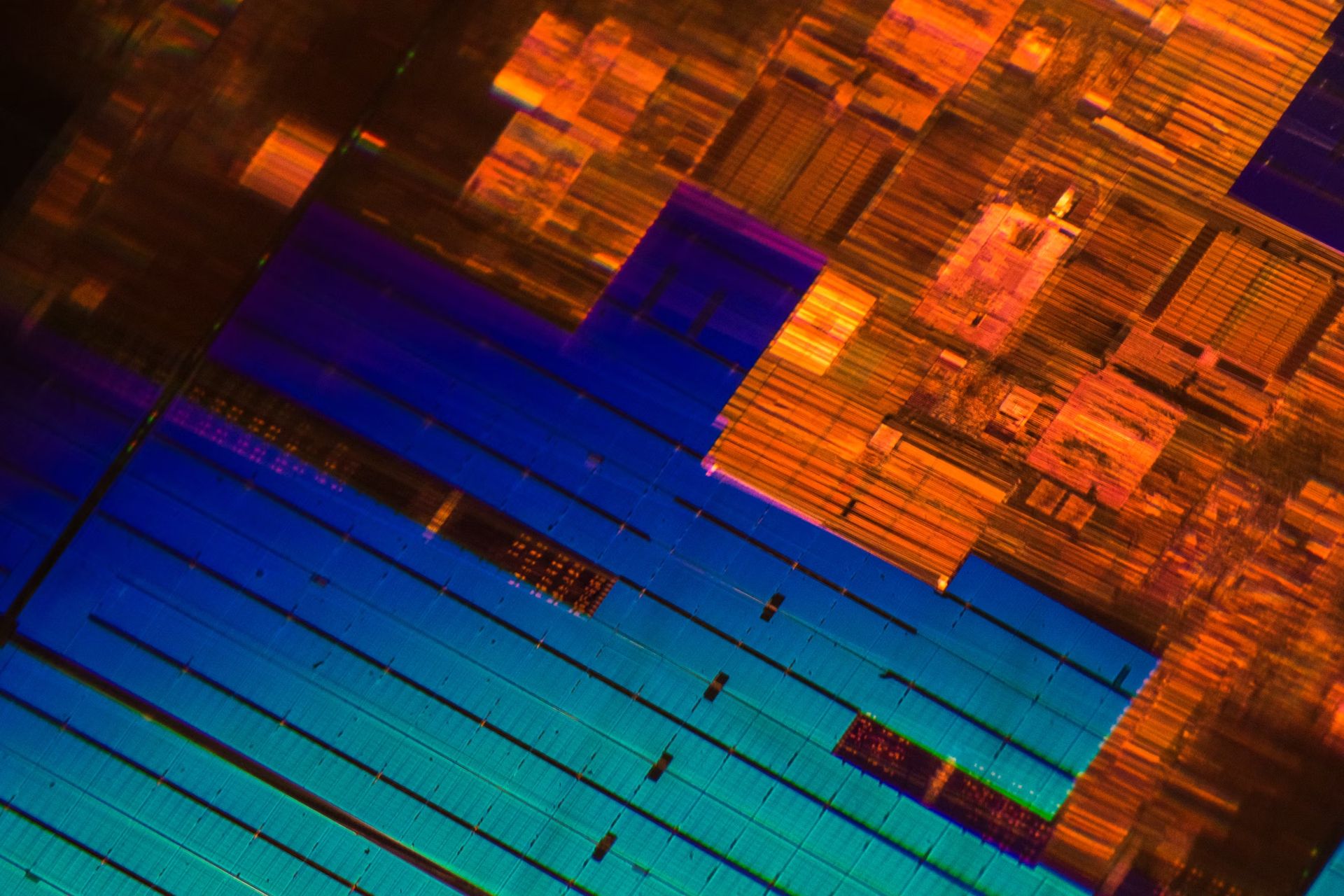

Włączenie chipów AMD w celu dywersyfikacji

Oprócz partnerstwa z Broadcom, OpenAI wykorzystuje także nowość AMD MI300X elementy konfiguracji Microsoft Azure. AMD wprowadziło te chipy w zeszłym roku w ramach swojej strategii rozwoju centrów danych, mającej na celu przejęcie części udziału w rynku posiadanego obecnie przez firmę NVIDIA. Włączenie chipów AMD pozwoli OpenAI zdywersyfikować dostawę chipów, zmniejszając jego zależność od jednego dostawcy i pomagając w skuteczniejszym zarządzaniu kosztami.

Chipy MI300X firmy AMD wpisują się w jej dążenie do konkurowania z firmą NVIDIA, która obecnie posiada ponad 80% udziału w rynku sprzętu AI. Chipy MI300X zostały zaprojektowane do obsługi obciążeń AI, szczególnie w zakresie wnioskowania i uczenia modeli. Dodając chipy AMD do swojej infrastruktury, OpenAI ma nadzieję złagodzić niektóre ograniczenia podaży, z którymi boryka się w przypadku procesorów graficznych NVIDIA, na które istnieje duże zapotrzebowanie i które są podatne na niedobory.

To strategiczne posunięcie jest także odpowiedzią na rosnące koszty obliczeń, które stały się poważnym wyzwaniem dla OpenAI. Firma boryka się z wysokimi wydatkami na sprzęt, energię elektryczną i usługi w chmurze, co prowadzi do przewidywanych strat w wysokości 5 miliardów dolarów w tym roku. Zmniejszenie zależności od jednego dostawcy, takiego jak NVIDIA, który podnosi ceny, mogłoby pomóc OpenAI lepiej zarządzać tymi kosztami i kontynuować rozwój modeli sztucznej inteligencji bez znaczących opóźnień i przerw.

Droga przed nami

Pomimo ambitnego planu opracowania niestandardowych chipów, przed OpenAI stoją poważne wyzwania. Budowa własnego rozwiązania krzemowego wymaga czasu i pieniędzy, a pierwsze specjalnie zaprojektowane chipy trafią do produkcji dopiero w 2026 roku. Ten harmonogram stawia OpenAI w tyle za niektórymi większymi konkurentami, takimi jak Google, Microsoft i Amazon, którzy już to zrobili poczyniła znaczne postępy w opracowywaniu własnego, niestandardowego sprzętu AI.

Partnerstwo z Broadcom i TSMC stanowi ważny krok naprzód, ale uwydatnia również trudności, jakie napotykają firmy próbujące włamać się na rynek chipów. Produkcja wysokowydajnych chipów AI wymaga znacznej wiedzy specjalistycznej, zaawansowanych urządzeń produkcyjnych i znacznych inwestycji. TSMC, jako partner produkcyjny, odegra kluczową rolę w określeniu powodzenia tego przedsięwzięcia. Harmonogram produkcji chipów może się jeszcze zmienić, w zależności od czynników takich jak złożoność projektu i możliwości produkcyjne.

Kolejnym wyzwaniem jest pozyskiwanie talentów. OpenAI ostrożnie podchodzi do pozyskiwania talentów od firmy NVIDIA, ponieważ chce utrzymać dobre relacje z producentem chipów, zwłaszcza że nadal w dużym stopniu polega na firmie NVIDIA w zakresie modeli sztucznej inteligencji obecnej generacji. Oczekuje się, że chipy NVIDIA Blackwell będą miały kluczowe znaczenie dla nadchodzących projektów AI, a utrzymywanie pozytywnych relacji jest niezbędne, aby OpenAI miał stały dostęp do tych najnowocześniejszych procesorów graficznych.

Dlaczego OpenAI potrzebuje niestandardowego krzemu

Głównym czynnikiem stojącym za inicjatywą OpenAI dotyczącą niestandardowych chipów są koszty. Szkolenie i wdrażanie dużych modeli sztucznej inteligencji, takich jak GPT-4, wymaga ogromnej mocy obliczeniowej, co przekłada się na wysokie wydatki na infrastrukturę. Przewiduje się, że roczne koszty obliczeniowe OpenAI będą jednym z największych wydatków, a firma spodziewa się w tym roku straty w wysokości 5 miliardów dolarów pomimo wygenerowania przychodów w wysokości 3,7 miliarda dolarów. Opracowując własne chipy, OpenAI ma nadzieję zapanować nad tymi kosztami, co zapewni jej przewagę konkurencyjną na zatłoczonym rynku sztucznej inteligencji.

Niestandardowy silikon zapewnia również korzyści w zakresie wydajności. Dostosowując chipy specjalnie do potrzeb wnioskowania AI, OpenAI może zoptymalizować wydajność, poprawić wydajność i zmniejszyć opóźnienia. Jest to szczególnie ważne w przypadku dostarczania wysokiej jakości odpowiedzi w czasie rzeczywistym w produktach takich jak ChatGPT. Chociaż procesory graficzne NVIDIA charakteryzują się dużą wydajnością, specjalnie zaprojektowany sprzęt może zapewnić bardziej ukierunkowaną optymalizację, potencjalnie prowadząc do znacznego wzrostu wydajności i efektywności kosztowej.

Podejście polegające na łączeniu wewnętrznych i zewnętrznych rozwiązań chipowych zapewnia OpenAI większą elastyczność w zakresie skalowania infrastruktury. Współpracując z Broadcom nad niestandardowymi projektami, wykorzystując jednocześnie procesory graficzne AMD i NVIDIA, OpenAI przygotowuje się do lepszego radzenia sobie z wyzwaniami związanymi z wysokim popytem i ograniczeniami łańcucha dostaw. To zróżnicowane podejście pomoże firmie dostosować się do zmieniających się warunków rynkowych i zapewni zasoby obliczeniowe niezbędne do dalszego przesuwania granic sztucznej inteligencji.

Autor wyróżnionego obrazu: Andrew Neel/Unsplash