Uniwersytet Tsinghua I Zhipu AI wprowadziliśmy we współpracy CogVideoX, model tekstowo-wideo typu open source, który ma rzucić wyzwanie gigantom w dziedzinie sztucznej inteligencji, takim jak Pas startowy, Sztuczna inteligencja LumaI Laboratoria Pika. Jak opisano w niedawnej publikacji arXiv, innowacja ta oferuje programistom na całym świecie zaawansowane możliwości generowania wideo.

CogVideoX: Nowe narzędzie typu open source do przetwarzania tekstu na wideo za pomocą sztucznej inteligencji

„Wprowadzamy CogVideoX, wielkoskalowe modele transformatorów dyfuzyjnych zaprojektowane do generowania filmów na podstawie podpowiedzi tekstowych. Aby skutecznie modelować dane wideo, proponujemy wykorzystanie 3D Variational Autoencoder (VAE) do kompresji filmów w wymiarach przestrzennych i czasowych. Aby poprawić wyrównanie tekstu i wideo, proponujemy ekspercki transformator z eksperckim adaptacyjnym LayerNorm, aby ułatwić głęboką fuzję między tymi dwoma modalnościami. Dzięki zastosowaniu progresywnej techniki szkoleniowej CogVideoX jest biegły w tworzeniu spójnych, długotrwałych filmów charakteryzujących się znaczącymi ruchami” papier czyta.

Niedawno współpracowali przy projekcie OpenVoice, platformie klonowania głosu z otwartym kodem źródłowym, opracowanej wspólnie z MIT i MojaPowłokaa teraz wprowadzili CogVideoX-5B, model do zamiany tekstu na wideo. Współpracowali również z Shengshu Technology, aby uruchomić Vidu AInarzędzie zaprojektowane w celu uproszczenia tworzenia filmów przy użyciu sztucznej inteligencji.

CogVideoX umożliwia tworzenie wysokiej jakości, spójnych filmów o długości do sześciu sekund na podstawie prostych poleceń tekstowych.

Wyróżniający się model, CogVideoX-5B, oferuje 5 miliardów parametrów, produkując filmy o rozdzielczości 720×480 i 8 klatkach na sekundę. Choć te specyfikacje mogą nie dorównywać najnowszym zastrzeżonym systemom, prawdziwy przełom tkwi w podejściu CogVideoX opartym na otwartym kodzie źródłowym.

Modele open source rewolucjonizują tę dziedzinę dzięki ruwalniając ich kod i wagi modeli dla opinii publicznej zespół Tsinghua skutecznie zdemokratyzował technologię, która kiedyś była domeną dobrze finansowanych gigantów technologicznych. Oczekuje się, że ten ruch przyspieszy postęp w dziedzinie wideo generowanego przez AI poprzez wykorzystanie zbiorowej wiedzy specjalistycznej globalnej społeczności programistów.

Naukowcy osiągnęli imponujące wyniki CogVideoX dzięki kilku kluczowym innowacjom, w tym Autoenkoder wariacyjny 3D do wydajnej kompresji wideo i „eksperckiego transformatora” zaprojektowanego w celu poprawy wyrównania tekstu i obrazu.

„Aby poprawić dopasowanie między filmami i tekstami, proponujemy eksperckiego Transformera z eksperckim adaptacyjnym LayerNorm, aby ułatwić fuzję między tymi dwoma modalnościami” – wyjaśnia artykuł. To przełomowe rozwiązanie umożliwia dokładniejszą interpretację podpowiedzi tekstowych i dokładniejsze generowanie wideo.

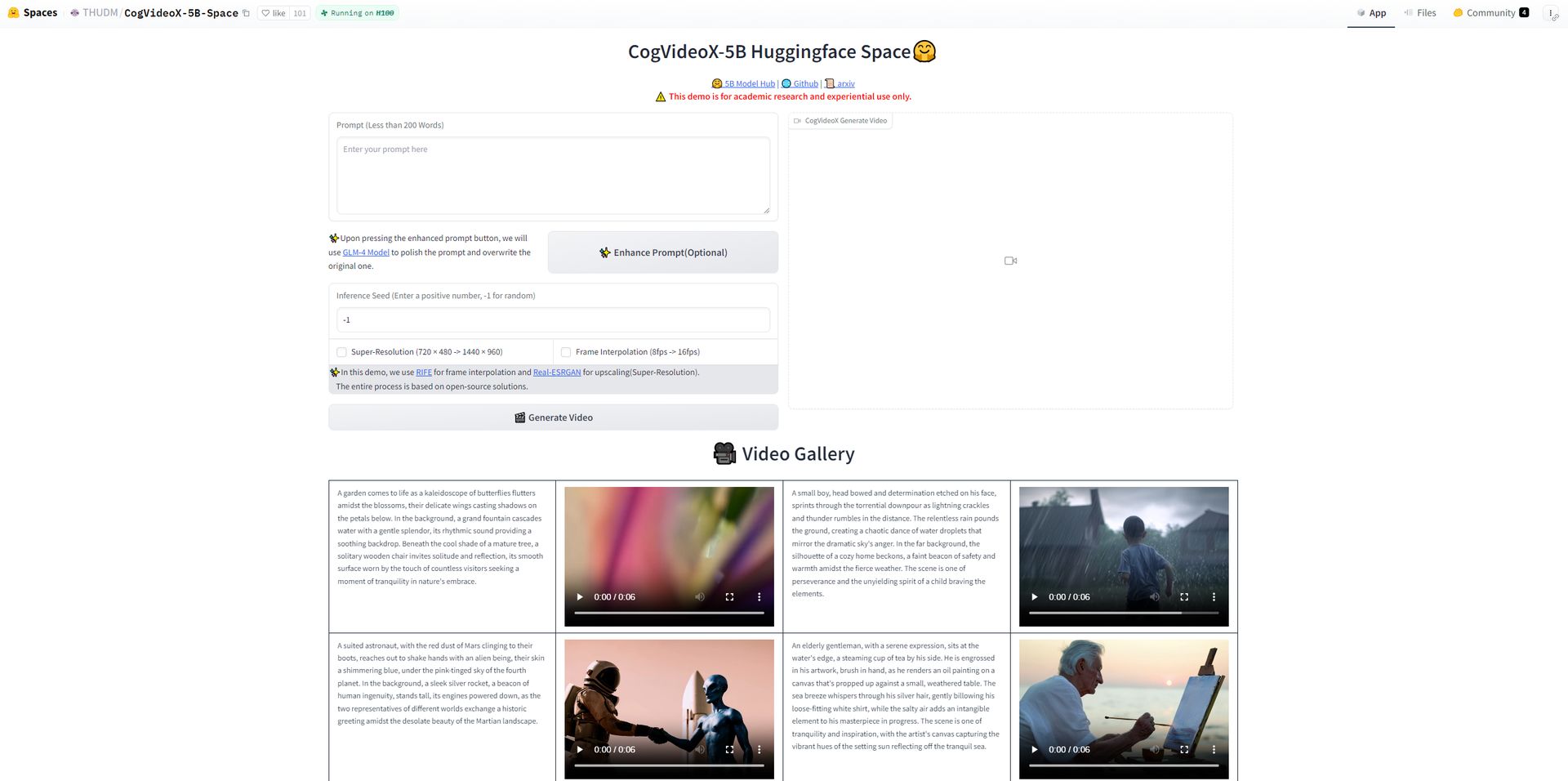

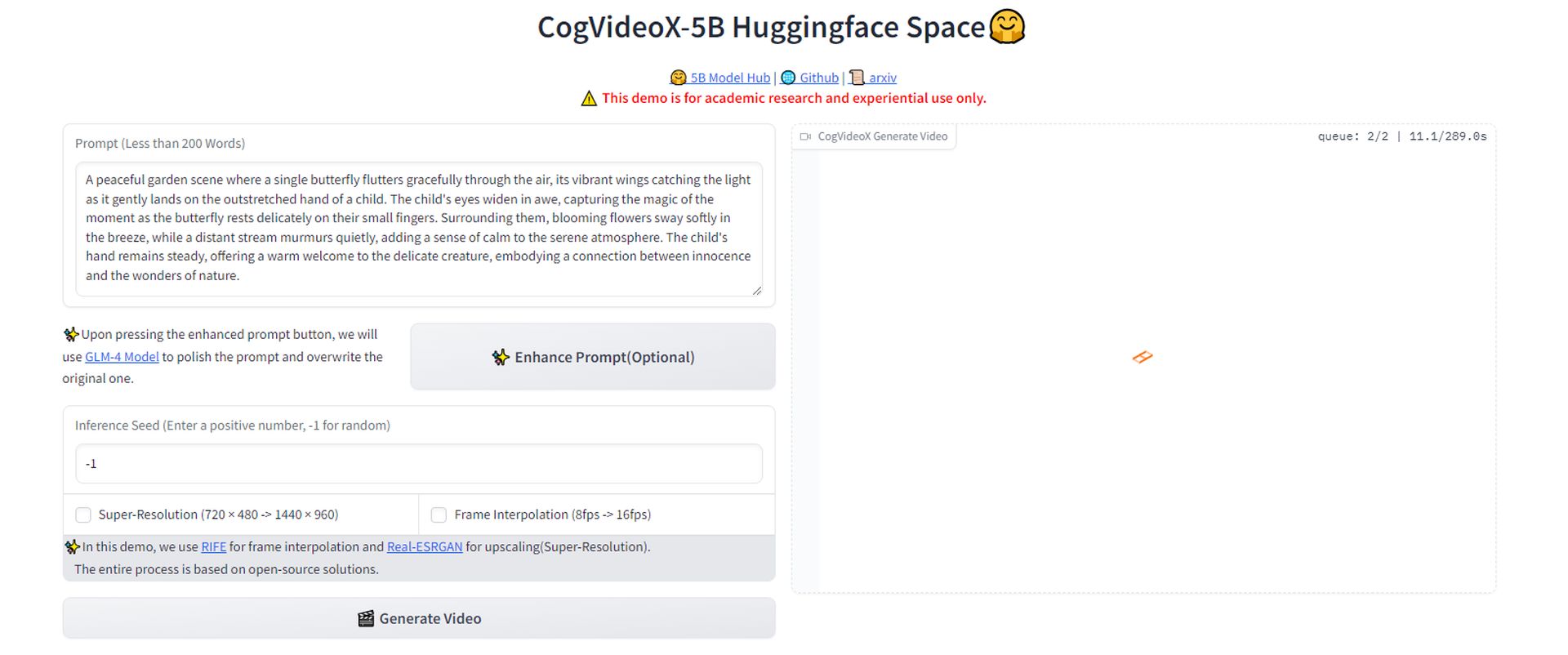

Jak wypróbować CogVideoX?

- Zacznij od przejścia na platformę HuggingFace gdzie CogVideoX-5B narzędzie do generowania wideo typu open source jest dostępny do testowania.

- Utwórz opisowy monit dla filmu, który chcesz wygenerować. Na przykład użyliśmy:

- Gdy Twój monit będzie gotowy, Kliknij przycisk, aby wygenerować wideo. Musisz chwilę poczekać, aż narzędzie przetworzy Twoje żądanie i utworzy film na podstawie Twojego opisu.

- Po wygenerowaniu filmu możesz go pobrać bezpośrednio z platformy. Dzięki temu możesz zobaczyć wynik swojego polecenia i przekonać się, jak dokładnie narzędzie zinterpretowało Twój opis.

- Obejrzyj wideo. Choć wynik może nie być oszałamiający, ważne jest, aby zauważyć, że tego typu narzędzia szybko się rozwijają. Tak jak widzieliśmy w przypadku ewolucji ChatGPT, znaczący przełom w wideo generowanym przez AI jest prawdopodobnie na horyzoncie.

Wypróbowałem to — chociaż jeszcze nie jest to oszałamiające, te narzędzia pojawiają się wszędzie. Spodziewam się rychłego przełomu, tak jak widzieliśmy w przypadku ChatGPT. fot.twitter.com/53xYz6lBLf

— Kerem Gülen (@kgulenn) 28 sierpnia 2024 r.

Będziemy widzieć coraz więcej deepfake’ów

Jednak szeroka dostępność tak potężnej technologii nie jest pozbawiona zagrożeń. Potencjalne nadużycia, szczególnie w tworzeniu deepfake’ów lub wprowadzających w błąd treści, to poważny problem, z którym musi zmierzyć się społeczność AI. Sami badacze dostrzegają te obawy etyczne, wzywając do odpowiedzialnego korzystania z technologii.

W miarę jak wideo generowane przez AI staje się coraz bardziej dostępne i zaawansowane, wkraczamy na nieznane terytorium w tworzeniu treści cyfrowych. Wprowadzenie CogVideoX może stanowić bardzo kluczowy moment, potencjalnie redystrybuując władzę od dużych graczy w tej dziedzinie do bardziej otwartego, zdecentralizowanego modelu rozwoju AI.

Prawdziwe skutki tej demokratyzacji są nadal niepewne. Czy stworzy nową falę kreatywności i innowacji, czy też pogorszy istniejące problemy dezinformacji i cyfrowej manipulacji?

Źródło wyróżnionego obrazu: Kerem Gülen/Środek podróży