Microsoft znalazł sposób na rywalizację z Nvidiaakcelerator AI Maia 100. Ten nowy chip stanowi strategiczny ruch mający na celu wyzwanie Dominacja firmy NVIDIA w sektorze sprzętu AI, oferując zaawansowane możliwości zaprojektowane dla wydajnego przetwarzania w chmurze. Dzięki Maia 100 firma Microsoft zamierza zapewnić bardziej opłacalne i wydajne rozwiązanie do zarządzania obciążeniami AI na dużą skalę.

Wszystko, co do tej pory wiemy o Maia 100 firmy Microsoft

Maia 100 firmy Microsoft to potężny nowy akcelerator AI zaprojektowany do obsługi dużych zadań AI w chmurze. Zaprezentowany na Gorące Frytki 2024, ten układ to duży krok naprzód w kierunku uczynienia infrastruktury AI bardziej opłacalną. Oto w jaki sposób:

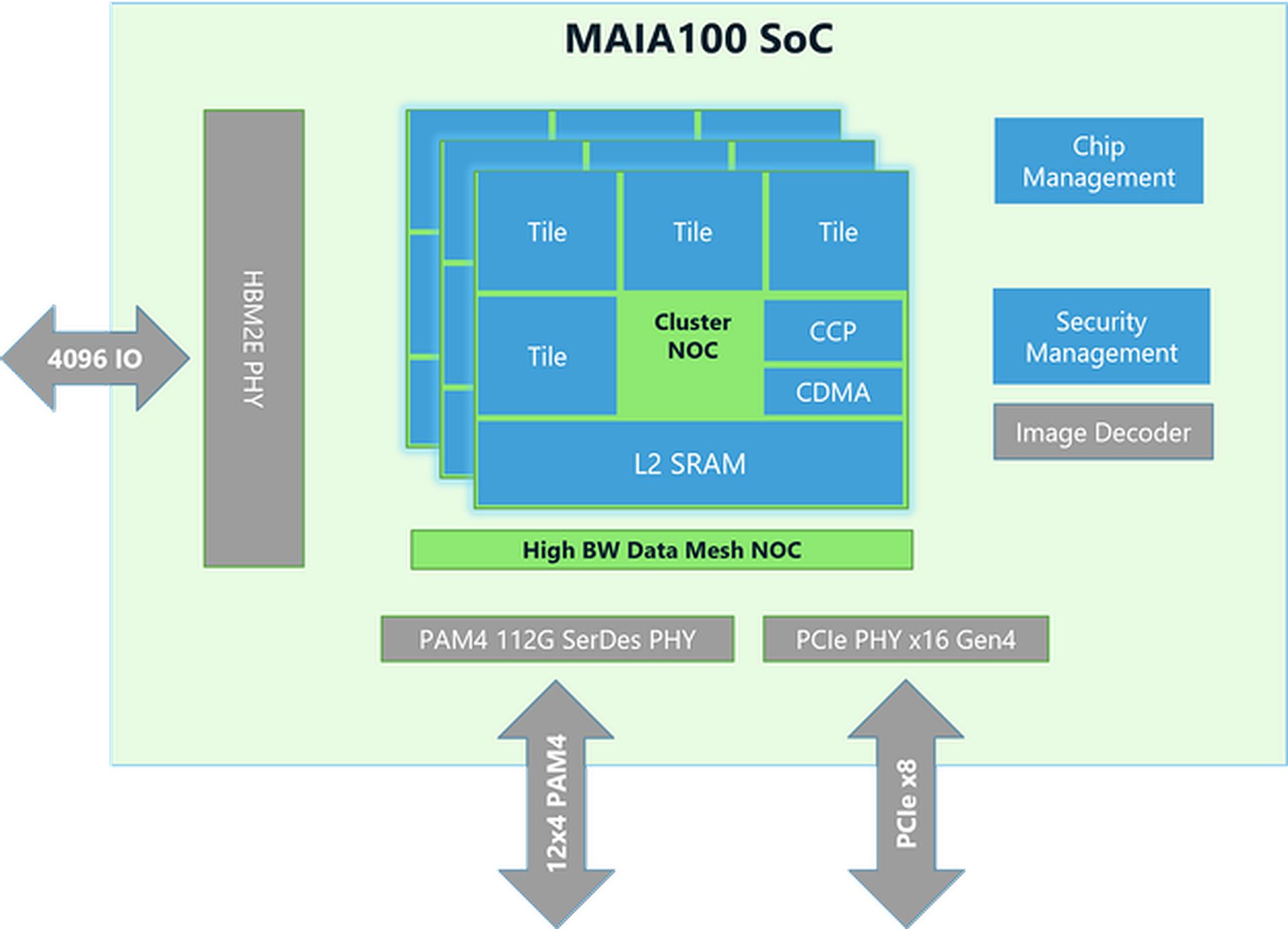

Projektowanie i technologia układów scalonych

- Rozmiar i produkcja:Chip Maia 100 ma rozmiar około 820 mm² i został zbudowany przy użyciu zaawansowanej technologii N5 firmy TSMC. Wykorzystuje technologię COWOS-S, która pomaga skutecznie zintegrować chip z innymi komponentami.

- Pamięć i przepustowość: Chip ma dużo pamięci i może obsłużyć ogromną ilość danych. Ma dużą pamięć SRAM on-die (rodzaj szybkiej pamięci) i cztery chipy pamięci HBM2E. Razem zapewniają 1,8 terabajta na sekundę prędkości transferu danych i 64 gigabajty pojemności pamięci. Ta konfiguracja jest kluczowa dla szybkiego przetwarzania dużych zestawów danych AI.

Wydajność i energooszczędność

- Zużycie energii: Maia 100 może obsługiwać do 700 watów mocy, ale jest ustawiona na 500 watów dla lepszej wydajności. Pozwala to na dobrą pracę przy jednoczesnym zachowaniu kontroli nad zużyciem energii.

- Jednostka tensorowa:Chip zawiera szybką jednostkę tensorową do obsługi złożonych zadań AI, takich jak modele szkoleniowe i tworzenie prognoz. Może przetwarzać różne typy danych, w tym nowy format o nazwie MX, który Microsoft wprowadził w 2023 r. Ta jednostka została zaprojektowana tak, aby sprawnie obsługiwać wiele obliczeń jednocześnie.

- Procesor wektorowy:Maia 100 ma procesor wektorowy, który obsługuje różne typy danych, takie jak FP32 (32-bitowy zmiennoprzecinkowy) i BF16 (16-bitowy zmiennoprzecinkowy). Pomaga to w wykonywaniu szerokiego zakresu zadań uczenia maszynowego.

- Silnik DMASilnik DMA (Direct Memory Access) pozwala na szybkie przesyłanie danych i obsługuje różne sposoby dzielenia tensorów (fragmentów danych), co zwiększa wydajność.

Przetwarzanie danych i wydajność

- Przechowywanie i kompresja danych:Maia 100 wykorzystuje pamięć masową danych o niższej precyzji i silnik kompresji, aby zmniejszyć ilość danych, które należy przenosić. Pomaga to w wydajniejszym wykonywaniu dużych zadań AI.

- Podkładki do drapania:Posiada duże dyski robocze L1 i L2 (miejsca tymczasowego przechowywania danych) zarządzane programowo, co zapewnia efektywne wykorzystanie danych i oszczędzanie energii.

- Sieciowanie:Chip obsługuje szybkie połączenia Ethernet, co pozwala mu obsługiwać do 4800 Gbps danych w niektórych sposobach i 1200 Gbps w innych. Ten niestandardowy protokół sieciowy zapewnia niezawodny i szybki transfer danych, który jest również bezpieczny dzięki szyfrowaniu AES-GCM.

Zamówienie Elona Muska na układ AI firmy Nvidia jest zbyt duże, aby je zrealizować

Narzędzia programowe i integracja

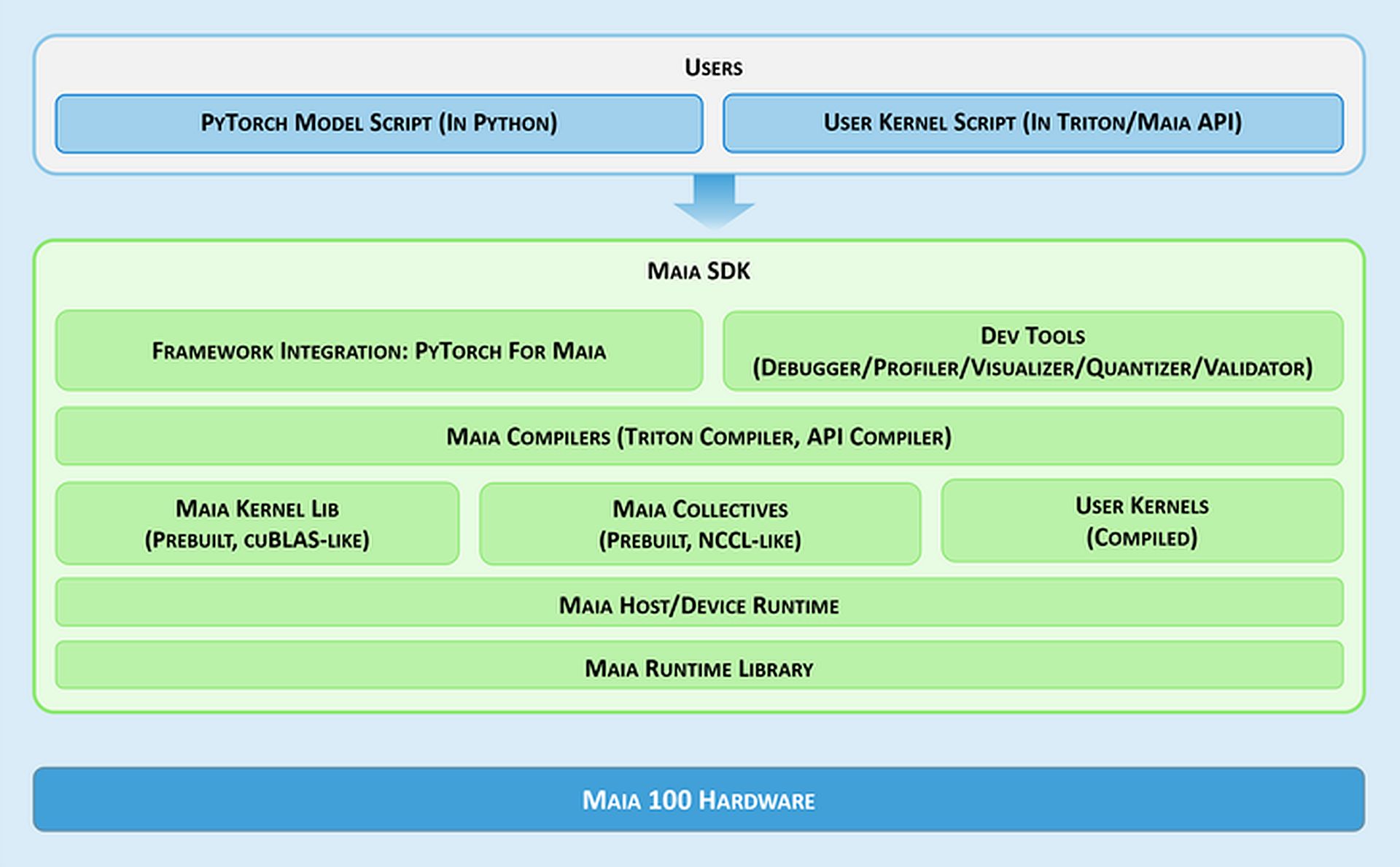

- Maia SDK:Microsoft udostępnia zestaw narzędzi o nazwie Maia SDK, aby ułatwić korzystanie z Maia 100. Narzędzia te obejmują:

- Integracja ramowa:Baza danych PyTorch obsługująca zarówno tryb chętny (do szybkiego tworzenia), jak i tryb graficzny (w celu lepszej wydajności).

- Narzędzia programistyczne:Narzędzia do debugowania, dostrajania wydajności i walidacji modeli, które pomagają w zwiększaniu efektywności zadań związanych ze sztuczną inteligencją.

- Kompilatory:Maia obsługuje dwa modele programowania: Triton, łatwy w użyciu język do głębokiego uczenia się, oraz Maia API, niestandardowy model zapewniający wysoką wydajność.

- Jądro i biblioteka zbiorcza:Zapewnia zoptymalizowane jądra obliczeniowe i komunikacyjne dla uczenia maszynowego, z opcją tworzenia niestandardowych jąder.

- Środowisko wykonawcze hosta/urządzenia:Zarządza alokacją pamięci, uruchamianiem programów, planowaniem zadań i zarządzaniem urządzeniami.

Modele programowania i obsługa danych

- Programowanie asynchroniczne:Maia obsługuje programowanie asynchroniczne z użyciem semaforów, co pozwala na nakładanie obliczeń na transfery danych, zwiększając w ten sposób wydajność.

- Modele programowania:Deweloperzy mogą wybierać pomiędzy:

- Tryton: Prosty wskaźnik planu dla głębokiego uczenia, który działa zarówno na GPU, jak i Maia. Automatycznie obsługuje pamięć i synchronizację.

- API Maia:Bardziej szczegółowy model programowania dla tych, którzy potrzebują dokładnej kontroli nad wydajnością, wymagając większej ilości kodu i zarządzania.

- Optymalizacja przepływu danych:Maia używa metody Gather-based do mnożenia macierzy (GEMM) zamiast tradycyjnej metody All-Reduce. Dzięki temu przetwarzanie jest szybsze poprzez łączenie wyników bezpośrednio w pamięci SRAM (szybka pamięć), co zmniejsza opóźnienie i poprawia wydajność.

- Użycie pamięci SRAM:Układ wykorzystuje pamięć SRAM do tymczasowego przechowywania danych i wyników, co ogranicza potrzebę wolniejszego dostępu do pamięci i zwiększa ogólną wydajność.

Elastyczność i przenośność

Maia 100 może uruchamiać modele PyTorch z minimalnymi zmianami. Back-end PyTorch obsługuje zarówno rozwój (tryb eager), jak i wysoką wydajność (tryb graph), co ułatwia przenoszenie modeli między różnymi konfiguracjami sprzętowymi.

Potrzebujesz podsumowania specyfikacji Maia 100?

| Specyfikacja | Bliższe dane |

| Rozmiar chipa | ~820mm² |

| Technologia produkcji | Proces TSMC N5 z interposerem COWOS-S |

| Pamięć SRAM On-Die | Duża pojemność umożliwiająca szybki dostęp do danych |

| Pamięć | 64 GB HBM2E (pamięć o dużej przepustowości) |

| Całkowita przepustowość | 1,8 terabajta na sekundę |

| Moc cieplna projektowa (TDP) | Obsługuje do 700 W, przy zasilaniu 500 W |

| Jednostka tensorowa | Wysoka prędkość, obsługuje format MX, 16xRx16 |

| Procesor wektorowy | Niestandardowy silnik superskalarny, obsługuje FP32 i BF16 |

| Silnik DMA | Obsługuje różne schematy fragmentacji tensora |

| Kompresja danych | Zawiera silnik kompresyjny dla zwiększenia wydajności |

| Szerokość pasma Ethernet | Do 4800 Gb/s w trybie zbierania całości, 1200 Gb/s w trybie all-to-all |

| Protokół sieciowy | Niestandardowe szyfrowanie AES-GCM podobne do RoCE |

| Modele programowania | Triton (język specyficzny dla domeny), Maia API (model niestandardowy) |

| Podkładki do drapania | Duże L1 i L2, zarządzane programowo |

| Wykorzystanie pamięci SRAM | Do buforowania aktywacji i wyników |

| Zestaw SDK oprogramowania | Zawiera zaplecze PyTorch, narzędzia do debugowania, kompilatory i zarządzanie środowiskiem wykonawczym |

| Optymalizacja przepływu danych | Mnożenie macierzy oparte na zbieraniu (GEMM) |

To wszystko! Podsumowując, akcelerator AI Maia 100 firmy Microsoft pozycjonuje się jako bezpośredni konkurent oferty firmy NVIDIA na rynku sprzętu AI. Dzięki zaawansowanej architekturze i funkcjom wydajnościowym Maia 100 ma na celu zapewnienie realnej alternatywy dla obsługi zadań AI na dużą skalę.

Źródło wyróżnionego obrazu: Microsoft