Wyścig o coraz większe modele sztucznej inteligencji jest cechą charakterystyczną ostatnich osiągnięć. Jednak Microsoft wprowadza zmiany, wprowadzając Phi-3 Mini, model AI oferujący imponujące możliwości pomimo niewielkich rozmiarów.

Tradycyjnie sukces dużych modeli językowych (LLM) łączono z liczbą parametrów – zasadniczo elementów składowych, które wpływają na zrozumienie języka przez model.

Biorąc pod uwagę koszty obliczeń i dostępność dla wszystkich, Microsoft Phi-3 jest tutaj, aby zmienić to „tradycyjne” podejście.

Microsoft Phi-3 Mini zmieści się w Twojej kieszeni olbrzyma

GPT-3.5, aktualny lider wyścigu LLM, może pochwalić się oszałamiającą liczbą 175 miliardów parametrów. Ta ogromna liczba pozwala GPT-3.5 przetwarzać ogromne ilości danych tekstowych, zapewniając szerokie i zróżnicowane zrozumienie języka. Jednak ta złożoność wiąże się również z kosztami. Uruchomienie modelu z tak dużą liczbą parametrów wymaga znacznych zasobów obliczeniowych, co czyni go kosztownym i energochłonnym.

Z kolei mini model Microsoftu przyjmuje inne podejście. Wykorzystując znacznie mniejszy zestaw parametrów – zaledwie 3,8 miliarda – Phi-3 Mini działa z poziomem wydajności, który przewyższa jego większe odpowiedniki. To zmniejszenie rozmiaru przekłada się na kilka korzyści.

Wszystko to sprawia, że Microsoft Phi-3:

- Znacznie tańsze w eksploatacji

- Potencjalna siła napędowa aplikacji AI na urządzeniach

Schemat szkolenia Phi-3 Mini

Kolejnym intrygującym aspektem Phi-3 Mini jest metoda treningu.

W przeciwieństwie do swoich większych odpowiedników szkolonych na ogromnych zbiorach danych zawierających tekst i kod, edukacja Phi-3 Mini wymagała bardziej wyselekcjonowanej selekcji. Badacze wybrali program nauczania inspirowany sposobem uczenia się dzieci, wykorzystując książki dla dzieci jako podstawę.

Wydaje się, że to podejście przyniosło pozytywne rezultaty, gdyż Phi-3 Mini wykazał wydajność porównywalną z GPT-3.5 na kilka benchmarków.

Test porównawczy zapewniający sukces

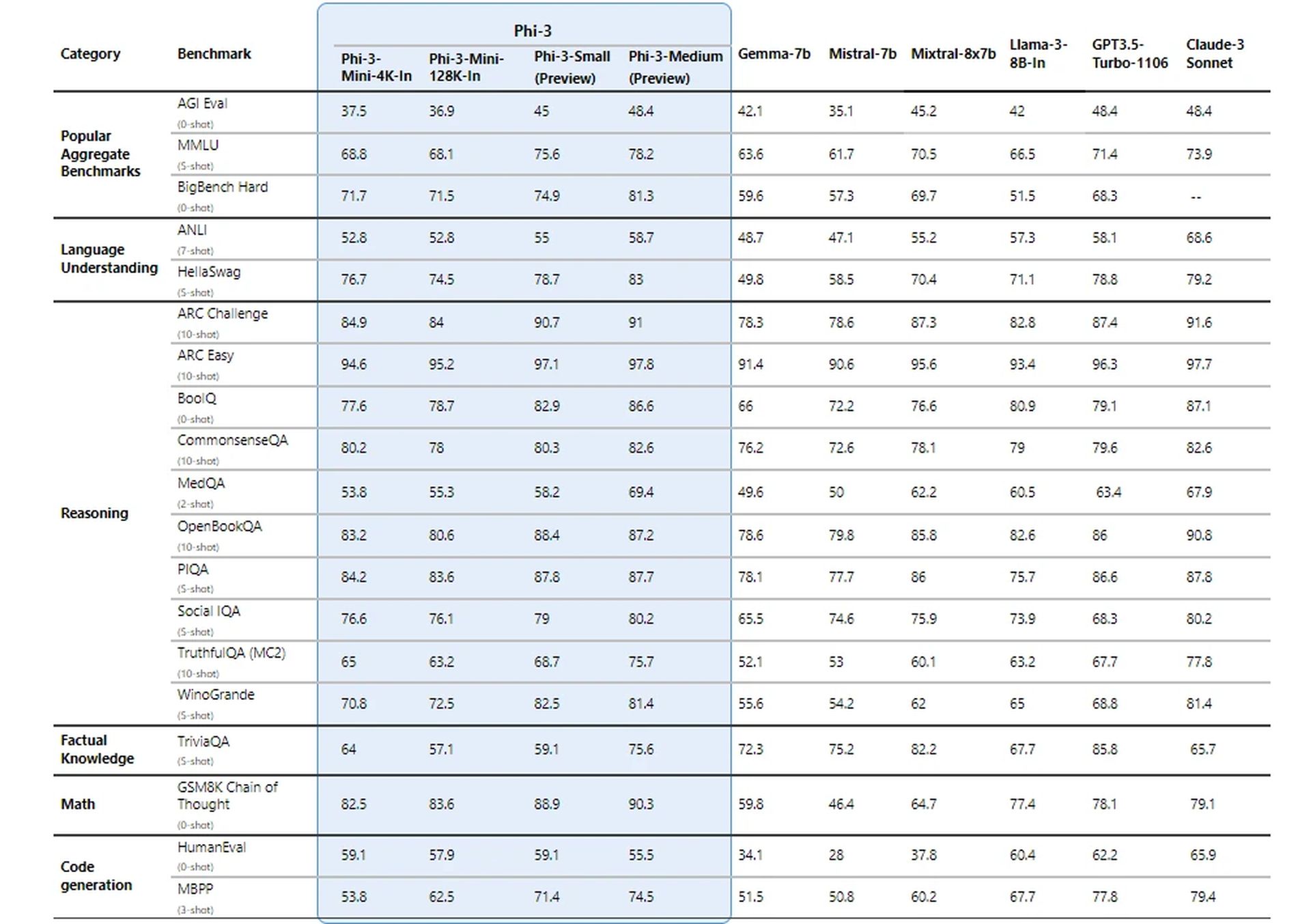

Badacze firmy Microsoft przetestowali swój nowy model, korzystając z ustalonych testów porównawczych dla LLM. Model uzyskał imponujące wyniki w takich miernikach, jak MMLU (miara zdolności modelu do rozumienia złożonych relacji w języku) i MT-bench (test możliwości tłumaczenia maszynowego).

Wyniki te sugerują, że Phi-3 Mini, pomimo swoich rozmiarów, może konkurować z wielkimi nazwiskami w grze LLM.

Jak osiąga tak imponujące wyniki?

Szczegóły techniczne Phi-3 Mini ujawniają fascynujące podejście do osiągania imponujących wyników przy wyjątkowo małym rozmiarze modelu. Oto zestawienie kluczowych aspektów:

Architektura dekodera transformatorowego

Phi-3 Mini wykorzystuje architekturę dekodera transformatorowego, powszechnie wybieraną przy projektowaniu efektywnych modeli językowych. Architektura ta doskonale radzi sobie z przetwarzaniem danych sekwencyjnych, takich jak tekst, umożliwiając modelowi zrozumienie relacji między słowami w zdaniu.

Długość kontekstu

Standardowy Phi-3 Mini działa z kontekstem o długości 4000 tokenów. Określa maksymalną liczbę tokenów (słów lub części słów), które model bierze pod uwagę podczas generowania tekstu. Dłuższy kontekst pozwala na głębsze zrozumienie poprzedzającej rozmowy, ale wymaga również większej mocy obliczeniowej.

Wersja z długim kontekstem (Phi-3-Mini-128K)

Do zadań wymagających szerszego kontekstu dostępny jest wariant o nazwie Phi-3-Mini-128K. Ta wersja zwiększa długość kontekstu do aż 128 000 tokenów, umożliwiając obsługę bardziej złożonych sekwencji informacji.

Kompatybilność z istniejącymi narzędziami

Aby przynieść korzyści społeczności programistów, Phi-3 Mini ma podobną strukturę i rozmiar słownictwa (320 641) z rodziną modeli Llama-2. Ta kompatybilność umożliwia programistom wykorzystanie istniejących narzędzi i bibliotek zaprojektowanych dla Llama-2 podczas pracy z Phi-3 Mini.

Parametry modelu

Oto, gdzie Phi-3 Mini naprawdę błyszczy. Mając zaledwie 3,072 miliarda parametrów, działa znacznie poniżej zdumiewających liczb obserwowanych w większych modelach, takich jak GPT-3.5 (175 miliardów parametrów).

To znaczne obniżenie parametrów przekłada się na wyjątkową wydajność w zakresie mocy obliczeniowej i wykorzystania pamięci.

Saif Naik z Microsoftu wyjaśnia:

„Naszym celem w przypadku drugiego pilota Krishi Mitra jest poprawa wydajności przy jednoczesnym zachowaniu dokładności dużego modelu językowego. Jesteśmy podekscytowani współpracą z firmą Microsoft przy korzystaniu z dopracowanych wersji Phi-3, aby osiągnąć oba nasze cele — wydajność i dokładność!”

– Saif Naik, dyrektor ds. technologii, ITCMAARS

Metodologia szkolenia

Szkolenie Phi-3 Mini czerpie inspirację z podejścia „Podręczniki są wszystkim, czego potrzebujesz”. W tej metodzie kładzie się nacisk na wysokiej jakości dane szkoleniowe, a nie na proste zwiększanie rozmiaru modelu. Dane szkoleniowe są starannie dobierane, koncentrując się na źródłach internetowych o określonym „poziomie edukacyjnym” i danych syntetycznych generowanych przez inne LLM.

Ta strategia pozwala Phi-3 Mini osiągnąć imponujące wyniki pomimo niewielkich rozmiarów.

Filtrowanie danych w celu optymalnego uczenia się

W przeciwieństwie do tradycyjnych podejść, które priorytetowo traktują zasoby obliczeniowe lub nadmierne szkolenie, Phi-3 Mini skupia się na „optymalnym reżimie danych” ze względu na swój rozmiar. Wiąże się to ze skrupulatnym filtrowaniem danych internetowych, aby upewnić się, że zawierają one odpowiedni poziom „wiedzy” i sprzyjają umiejętnościom rozumowania.

Na przykład ogólne dane sportowe mogą zostać wykluczone, aby nadać priorytet informacjom, które poprawiają zdolność modelu do rozumowania.

Dopracowanie po treningu

Po podstawowym procesie szkolenia nowy model przechodzi dodatkowe udoskonalenia poprzez nadzorowane dostrajanie (SFT) i bezpośrednią optymalizację preferencji (DPO). SFT udostępnia model wyselekcjonowanym danym z różnych dziedzin, w tym matematyki, kodowania i zasad bezpieczeństwa. DPO pomaga skierować model z dala od niepożądanych zachowań, identyfikując i wykluczając niepożądane wyniki.

Ta faza poszkoleniowa przekształca Phi-3 Mini z modelu językowego w wszechstronnego i bezpiecznego asystenta AI.

Wydajna wydajność na urządzeniu

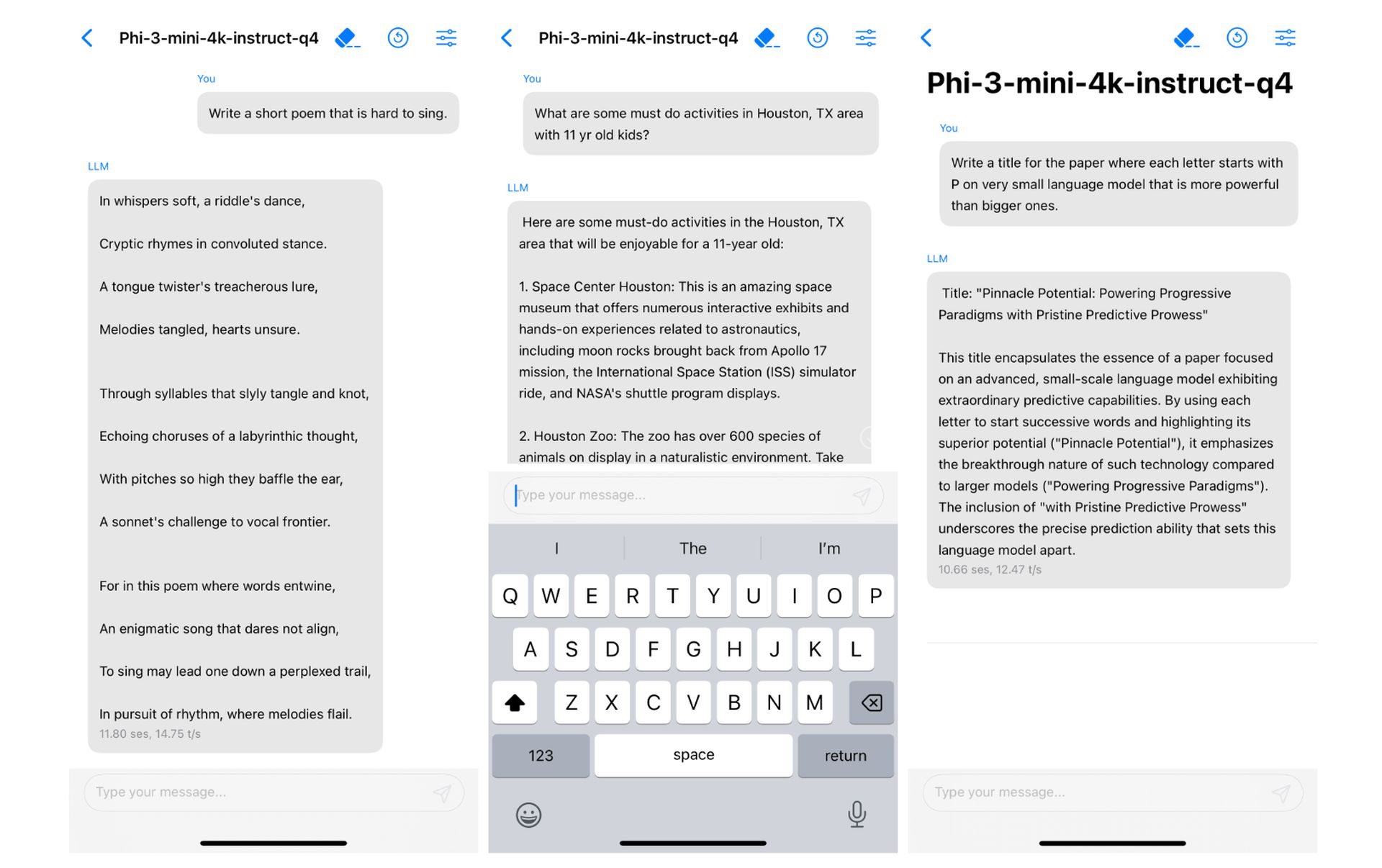

Niewielki rozmiar Phi-3 Mini przekłada się na wyjątkową wydajność urządzenia. Kwantując model do 4 bitów, zajmuje on zaledwie 1,8 gigabajta pamięci.

Idealne połączenie

Pamiętacie nieudane próby smartfonów Microsoftu? Co powiesz na Nieudane oferty integracji Apple z Google Gemini w ostatnich miesiącach? A może śledziłeś wiadomości o tym, że Apple głośno wypowiada się na temat integracji LLM na urządzeniu z systemem iOS 18 w ciągu ostatnich kilku tygodni?

Czy to dzwoni?

Potencjalne zastosowania Phi-3 Mini są ogromne. Jego wydajność sprawia, że idealnie nadaje się do integracji z urządzeniami mobilnymi, potencjalnie umożliwiając korzystanie z takich funkcji, jak inteligentniejsi wirtualni asystenci i tłumaczenie językowe w czasie rzeczywistym. Ponadto jego opłacalność może otworzyć drzwi do szerszego zastosowania przez programistów pracujących nad różnymi projektami opartymi na sztucznej inteligencji.

I właśnie tego szukał Apple. Oczywiście to twierdzenie jest na razie niczym więcej niż domysłem, ale nie byłoby błędem stwierdzenie, że jest to „dopasowanie dokonane w niebie”. Poza tym w artykule badawczym omówiono nowy projekt Microsoftu został już uruchomiony na iPhonie z natywnym chipem A16 Bionic.

Sukces Phi-3 Mini zależy od kombinacji czynników – dobrze dopasowanej architektury, efektywnego wykorzystania długości kontekstu, kompatybilności z istniejącymi narzędziami, skupienia się na wysokiej jakości danych szkoleniowych i technikach optymalizacji. To unikalne podejście toruje drogę potężnym i wydajnym modelom sztucznej inteligencji, które mogą bezproblemowo działać na urządzeniach osobistych.

Autor wyróżnionego obrazu: vecstock/Freepik