Meta zrobiony jest to nowy open-source Llama 3 LLM, który można uruchomić lokalnie za pomocą Ollama. Udostępniając Llama 3 jako open source, Meta odblokowała bogactwo potencjału dla firm każdej wielkości. Oznacza to, że podstawowy kod Lamy 3 jest swobodnie dostępny do sprawdzenia, adaptacji i wykorzystania przez każdą zainteresowaną stronę. Konsekwencje dla społeczności biznesowej, zwłaszcza małych i średnich przedsiębiorstw, są znaczące.

Dzięki liberalnej strukturze licencjonowania MŚP mogą wykorzystać moc Lamy 3 do swoich konkretnych projektów bez napotykania uciążliwych ograniczeń. Tak długo jak przestrzegane są ustalone standardy prawne, MŚP mają swobodę odkrywania szerokiego potencjału tej najnowocześniejszej technologii.

Co to jest Lama 3?

Llama 3 to LLM opracowany przez Meta, a firma twierdzi, że jest to „najbardziej wydajny, dostępny obecnie LLM”.

Lama 3 występuje w dwóch rozmiarach: 8 miliardów i 70 miliardów parametrów. Ten rodzaj modelu jest szkolony na ogromnej ilości danych tekstowych i może być używany do różnych zadań, w tym do generowania tekstu, tłumaczenia języków, pisania różnego rodzaju kreatywnych treści i odpowiadania na pytania w sposób informacyjny. Meta zachwala Llamę 3 jako jeden z najlepszych dostępnych otwartych modeli, ale jest on wciąż w fazie rozwoju.

„Dzięki Llama 3 postanowiliśmy zbudować najlepsze otwarte modele, które dorównują najlepszym dostępnym obecnie modelom zastrzeżonym” – czytamy w poście na blogu Meta.

Modele Lamy 3 wykorzystują dane, aby osiągnąć bezprecedensowe skalowanie. Zostali przeszkoleni przy użyciu dwóch nowo zaprezentowanych, niestandardowych klastrów GPU 24K na ponad 15 bilionach tokenów danych. Ten zestaw danych szkoleniowych jest siedmiokrotnie większy niż ten używany w Llama 2 i zawiera czterokrotnie więcej kodu, co znacznie zwiększa ich możliwości i zakres wiedzy.

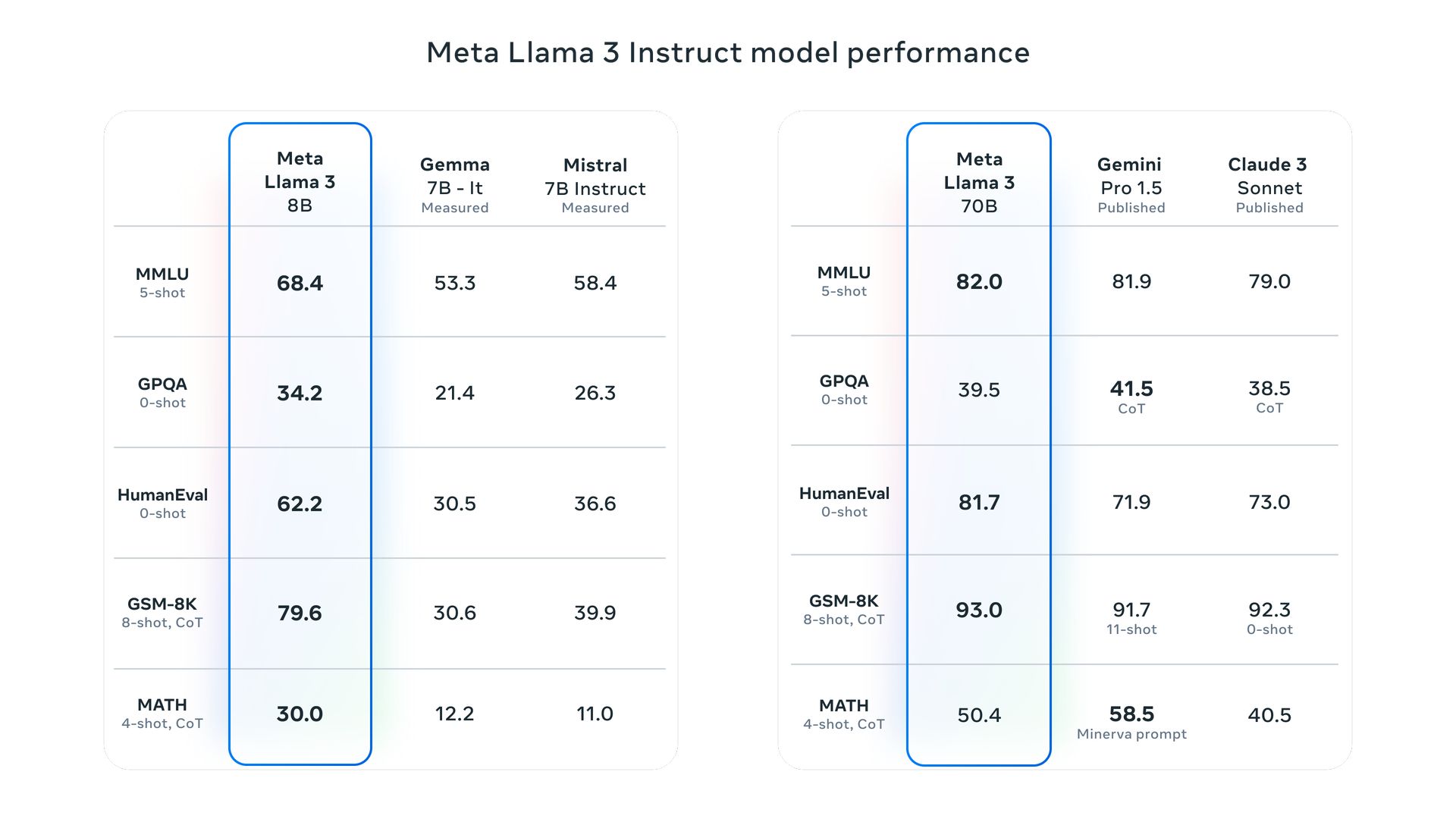

Omówiliśmy Testy porównawcze Lamy 3 pokazujące, jak model osiągnął wyjątkową wydajność we wszystkich ocenianych zadaniach.

W jaki sposób Meta Llama 3 poprawia się w porównaniu z poprzednimi wersjami?

Modele Meta Llama 3 przeszły znaczące ulepszenia w procesach wstępnego uczenia i dostrajania, co zwiększa ich zdolność do lepszego dostosowania się do instrukcji użytkownika, generowania bardziej zróżnicowanych odpowiedzi i zmniejszenia poziomu błędów. Kluczowe udoskonalenia technologiczne obejmują bardziej wydajny tokenizator i funkcję Group Query Attention (GQA), poprawiającą efektywność wnioskowania.

Czy Llama 3 jest multimodalna?

Obecnie Llama 3 w niektórych zastosowaniach obsługuje zarówno dane tekstowe, jak i wizualne, ale Meta ma na celu ulepszenie swoich możliwości przetwarzania obrazu. Do końca 2024 r. planują wypuścić Llamę 4, zaprojektowaną tak, aby wyróżniała się interpretacją i generowaniem skomplikowanych obrazów na podstawie opisów tekstowych.

Postęp ten umożliwi wyrafinowane modyfikacje obrazu, ulepszenia przedstawiania scen i tworzenie realistycznych obrazów w różnych stylach, łącząc możliwości rozumienia języka i percepcji wizualnej w celu uzyskania bardziej imponujących wyników.

Jak uzyskać dostęp do Lamy 3?

Dostęp do Lamy 3 jest obecnie możliwy lokalnie poprzez Ollamę, co ułatwia wdrażanie i obsługę dużych modeli językowych.

Co robi Ollama?

Ollama zapewnia platformę do uruchamiania dużych modeli językowych typu open source, takich jak Llama 2, w systemach lokalnych. Integruje wagi modeli, konfigurację i niezbędne dane w ujednolicony pakiet określony przez plik modelu i upraszcza proces konfiguracji, w tym optymalizację wykorzystania procesora graficznego w celu zwiększenia wydajności.

Czy Ollama jest dostępna w systemie Windows?

Jeśli chodzi o kompatybilność, Ollama jest teraz dostępna w systemie Windows w wersji zapoznawczej. To wydanie umożliwia użytkownikom zarządzanie dużymi modelami językowymi bezpośrednio w systemie Windows, oferując akcelerację GPU, pełny dostęp do biblioteki modeli i interfejs API Ollama obsługujący protokoły OpenAI.

Jak działa Ollama?

Ollama wykorzystuje architekturę transformatorową, rodzaj modelu głębokiego uczenia się, który ma kluczowe znaczenie w przypadku dużych modeli językowych. Analizując obszerne dane tekstowe, Ollama opanowuje niuanse języka, umożliwiając mu zrozumienie kontekstu zapytań, udzielanie poprawnych składniowo i kontekstowo znaczących odpowiedzi oraz wykonywanie dokładnego tłumaczenia językowego, uchwycając istotę języka źródłowego i skutecznie przekazując go w języku docelowym język.

Czy Llama 3 będzie oprogramowaniem typu open source?

Jeśli chodzi o dostępność, Meta oświadczyła, że Llama 3 jest oprogramowaniem typu open source promującym szerszą dostępność i innowacje w społeczności technologicznej.

Czy mogę uruchomić Llamę 3 lokalnie?

Tak, Ollama ułatwia wykonywanie różnych dużych modeli językowych, w tym Lamy 3, na komputerach osobistych. Wykorzystuje wydajność llama.cpp, biblioteki typu open source, która umożliwia lokalne działanie LLM nawet w systemach o skromnych specyfikacjach sprzętowych. Dodatkowo Ollama zawiera rodzaj menedżera pakietów, który upraszcza proces pobierania i wykorzystywania LLM za pomocą jednego polecenia, zwiększając zarówno szybkość, jak i łatwość użycia.

Jakie funkcje bezpieczeństwa są zintegrowane z Meta Llama 3?

Meta zintegrowała kilka funkcji bezpieczeństwa w Llama 3, takich jak Llama Guard 2 i Cybersec Eval 2, aby rozwiązać problemy związane z bezpieczeństwem. Narzędzia te pomagają w filtrowaniu problematycznych wyników i zapewnieniu bezpiecznego wdrożenia. Dodatkowo modele poddano analizie red-team w celu przetestowania i udoskonalenia ich reakcji na sygnały wejściowe od przeciwników.

Jakie są przyszłe cele Meta Llama 3?

Meta planuje rozszerzyć Llamę 3, aby obsługiwała możliwości wielojęzyczne i multimodalne, obsługiwała dłuższe konteksty i jeszcze bardziej zwiększała wydajność we wszystkich podstawowych możliwościach modeli językowych. Celem jest również pozostawienie modeli otwartych na zaangażowanie społeczności i iteracyjne ulepszenia.

Autor wyróżnionego obrazu: Meta