- Cerebras Systems przedstawia silnik Wafer Scale Engine 3 (WSE-3), reklamowany jako najbardziej zaawansowany układ AI na świecie, napędzający superkomputer CS-3 AI z maksymalną wydajnością 125 petaFLOPS.

- Chip WSE-3 obiecuje zrewolucjonizować szkolenie AI, znacznie zwiększając wydajność przy jednoczesnym zachowaniu efektywności kosztowej i energetycznej, oferując cztery biliony tranzystorów i dwukrotnie większą wydajność niż jego poprzednik.

- System CS-3, wyposażony w 900 000 rdzeni AI i do 1,2 petabajta pamięci zewnętrznej, teoretycznie plasuje się wśród 10 najlepszych superkomputerów na świecie, wykazując niespotykany dotąd potencjał w zakresie uczenia modeli sztucznej inteligencji i skalowalności.

Technologia sztucznej inteligencji, przez niektórych uważana za pionierską innowację, a przez innych krytykowana jako dobrodziejstwo dla elity, ma teraz w swoim arsenale przełomowy atut. Cerebras Systems uchyli zasłonę co jest uważane za najbardziej zaawansowany chip AI na świecie, Wafer Scale Engine 3 (WSE-3). Ta potężna jednostka napędza superkomputer Cerebras CS-3 AI, który może poszczycić się niezrównaną wydajnością szczytową na poziomie 125 petaFLOPS i skalowalnością, która przesuwa granice tego, co jest możliwe.

Co ma do zaoferowania Cerebras WSE-3?

Kluczowe specyfikacje wyszczególnione w komunikat prasowy:

- 4 biliony tranzystorów

- 900 000 rdzeni AI

- 125 petaflopów maksymalnej wydajności AI

- 44 GB na chipie SRAM

- Proces TSMC 5 nm

- Pamięć zewnętrzna: 1,5 TB, 12 TB, Lub 1,2 PB

- Trenuje modele AI do 24 bilionów parametrów

- Rozmiar klastra do 2048 systemów CS-3

Zanim sztuczna inteligencja będzie w stanie wygenerować te urzekające filmy i obrazy, przechodzi szkolenie na kolosalnej skali danychpożerając odpowiednik energii ponad 100 gospodarstw domowych w procesie. Jednak ten najnowocześniejszy chip wraz z wykorzystującymi go systemami komputerowymi obiecuje znacznie przyspieszyć i zwiększyć wydajność tej fazy szkoleniowej.

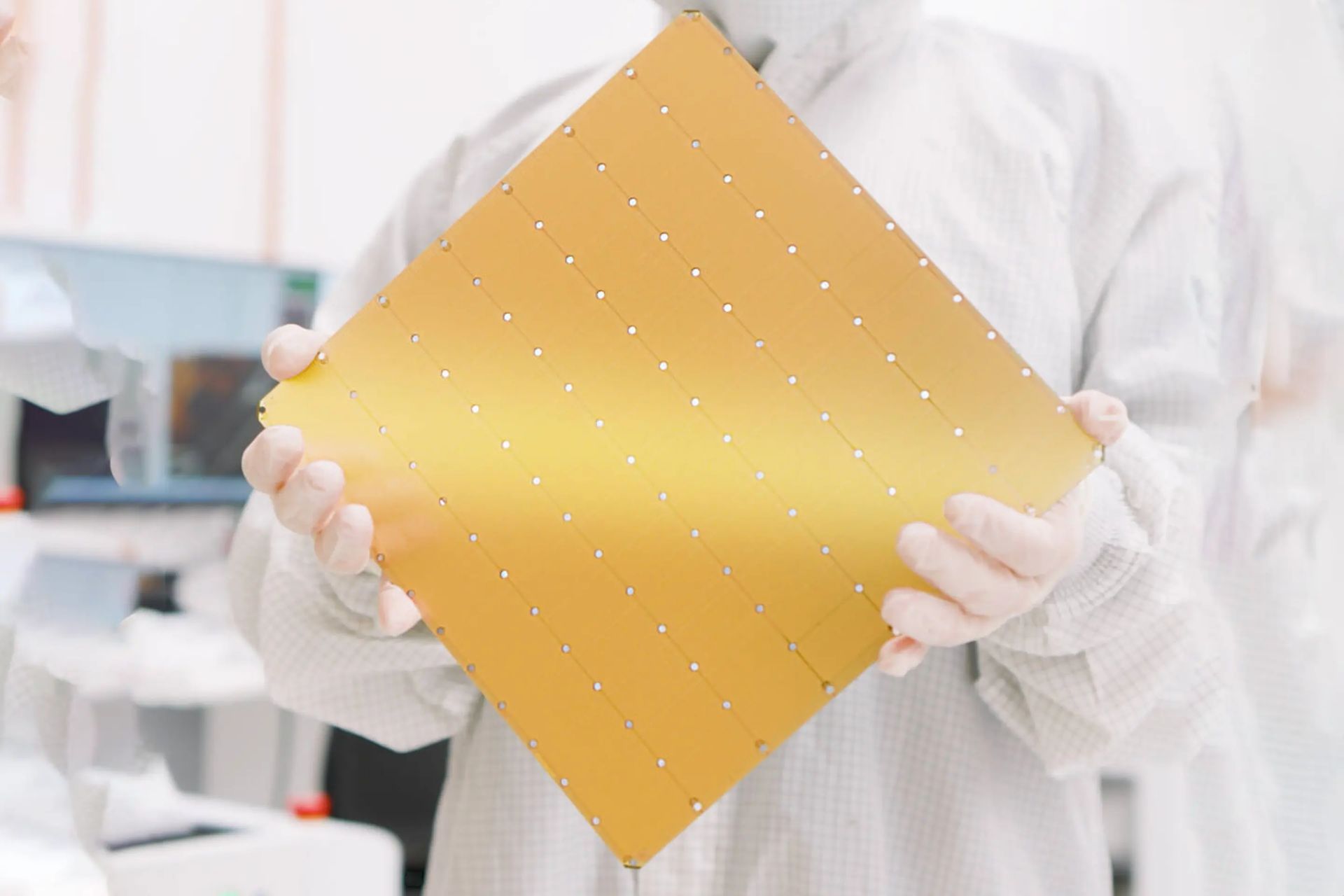

Układ WSE-3, wielkością porównywalną do standardowej gry planszowej, jest wyjątkowo wyposażony w cztery biliony tranzystorów, osiągając dwukrotnie większą wydajność niż poprzednia wersja Cerebras Systems – byłego mistrza pod względem szybkości – a wszystko to przy zachowaniu tych samych kosztów i efektywności energetycznej. Zintegrowane z systemem CS-3 chipy te zapewniają moc obliczeniową odpowiadającą całej serwerowni, a wszystko to zamknięte w jednostce wielkości zaledwie małej lodówki.

Stany Zjednoczone negocjują sprzedaż chipów AI z Nvidią w obliczu napięć w Chinach

Cerebras podkreśla, że CS-3 może pochwalić się 900 000 rdzeni AI i 44 GB wbudowanej pamięci SRAMzdolny do osiągnięcia szczytowej wydajności AI wynoszącej 125 petaFLOPÓW. Teoretycznie imponująca specyfikacja plasuje CS-3 wśród 10 najlepszych superkomputerów na świecie. Jednak bez testów porównawczych rzeczywista wydajność w rzeczywistych zastosowaniach pozostaje spekulacyjna.

Odpowiadając na nienasycone zapotrzebowanie sztucznej inteligencji na dane, CS-3 oferuje konfiguracje pamięci zewnętrznej w zakresie od 1,5 TB do 1,2 petabajta (PB), co odpowiada 1200 TB. Ta pojemność umożliwia szkolenie modeli AI maksymalnie 24 biliony parametrów, co przyćmiewa rozmiar większości obecnych modeli sztucznej inteligencji, których parametry liczą się w miliardach, przy czym GPT-4 szacuje się na około 1,8 biliona. Cerebras sugeruje CS-3 mógł trenować modele z bilionem parametrów z taką samą łatwością, z jaką współczesne systemy oparte na procesorach graficznych radzą sobie z modelami z miliardem parametrów.

Innowacyjny proces produkcji płytek zastosowany w chipach WSE-3 pozwala na skalowalną konstrukcję CS-3. Obsługuje grupowanie do 2048 jednostek, czego kulminacją jest gigant superkomputerowy zdolny osiągnąć 256 exaFLOPS. Przyćmiłoby to wydajność wiodących superkomputerów na świecie, które obecnie działają nieco powyżej jednego exaFLOP-a. Cerebras twierdzi, że te niezrównane możliwości mogłyby ułatwić wyszkolenie modelu Lamy 70B od podstaw w ciągu zaledwie jednego dnia.

Autor wyróżnionego obrazu: Kerem Gülen/Midjourney