Czy kiedykolwiek marzyłeś, aby Twoje zdjęcia mogły mówić lub śpiewać? Poznaj EMO, skrót od Emote Portrait Alive. Opracowany przez naukowców z Instytutu Inteligentnych Obliczeń Alibaba, EMO to system sztucznej inteligencji zaprojektowany właśnie do tego.

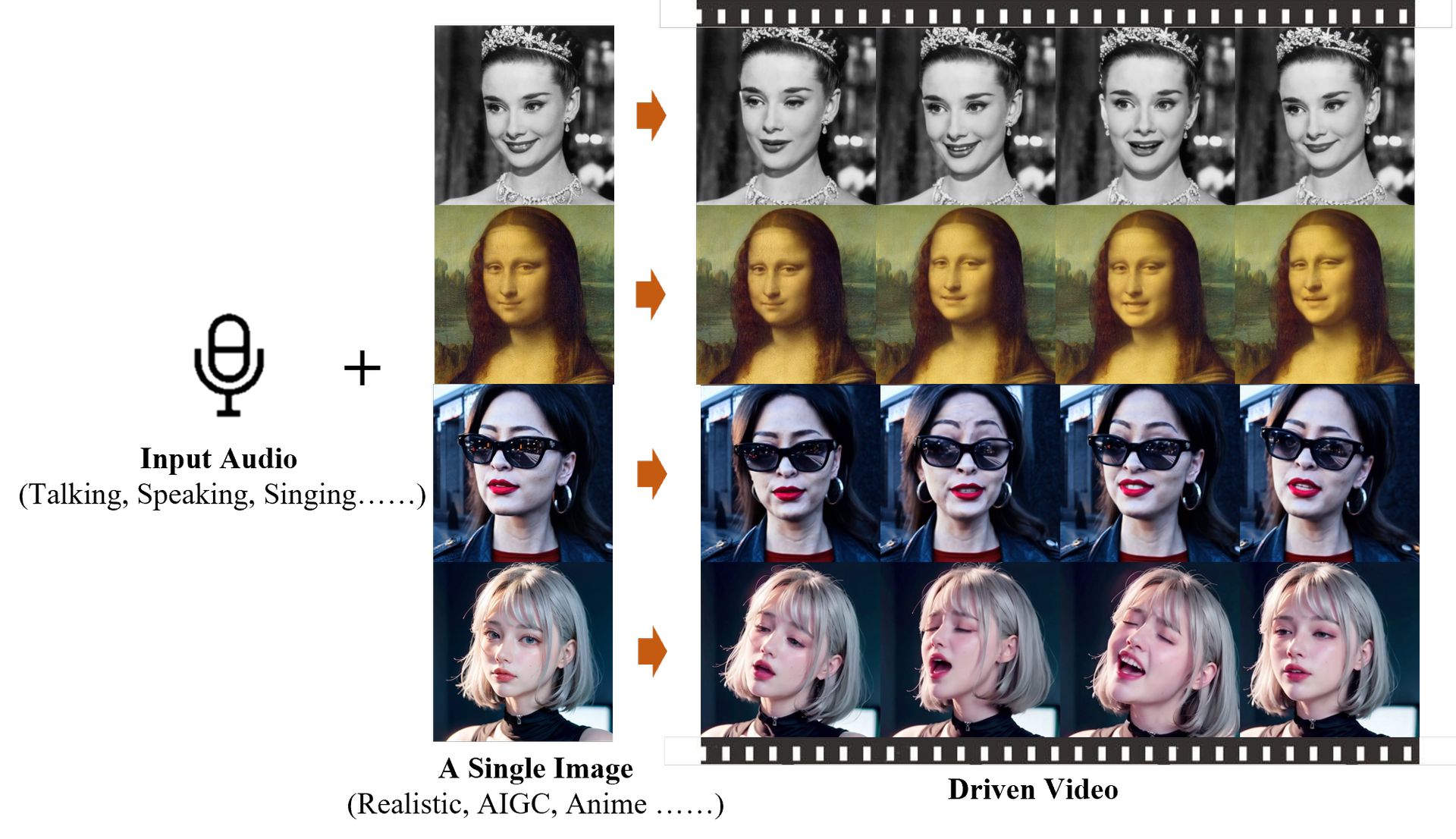

EMO ma unikalne podejście do animacji, omijając złożone modele 3D, bezpośrednio konwertując dźwięk na klatki wideo. Oznacza to, że Twoje animowane filmy zachowują naturalne ruchy i ekspresję mowy lub piosenki, a wszystko to z jednego zdjęcia i klipu audio.

Alibaba AI: Co to jest żywy portret emotki (EMO)?

EMO, czyli Emote Portrait Alive, to system sztucznej inteligencji opracowany przez naukowców z Instytutu Inteligentnych Obliczeń Alibaba. Jego podstawową funkcją jest animuj statyczne zdjęcia portretowetworząc filmy, w których fotografowana osoba wydaje się realistycznie mówić lub śpiewać.

To, co wyróżnia EMO, to podejście do generowania tych animacji. Zamiast polegać na tradycyjnych metodach, które często mają problemy z uchwyceniem niuansów ludzkiej ekspresji, EMO bezpośrednio konwertuje przebiegi audio na klatki wideo. Oznacza to, że do generowania animacji nie są potrzebne pośrednie modele 3D ani punkty orientacyjne twarzy. Zamiast tego skupia się na uchwyceniu subtelnych ruchów twarzy i indywidualnych stylów twarzy związanych z naturalną mową.

Właśnie w

to najbardziej niesamowite audio2video, jakie kiedykolwiek widziałem.

Nazywa się EMO: Emote Portrait Alive pic.twitter.com/3b1AQMzPYu— Stelfie podróżnik w czasie (@StelfieTT) 28 lutego 2024 r

Technologia, na której opiera się EMO, opiera się na modelu dyfuzyjnym, który jest dobrze znany ze swojej zdolności do generowania realistycznych, syntetycznych obrazów. Do szkolenia systemu badacze wykorzystali duży zbiór danych zawierających nagrania wideo gadających głów z różnych źródeł, w tym przemówień, filmów, programów telewizyjnych i występów muzycznych. Dzięki temu obszernemu szkoleniu firma EMO może tworzyć wysokiej jakości filmy wideo, zachowując jednocześnie tożsamość tematu i przekazując wyrazistość.

Oprócz generowania filmów konwersacyjnych EMO może również animować portrety ze śpiewem. Synchronizacja kształtów ust i wyrazu twarzy z wokalem pozwala tworzyć filmy ze śpiewem w różnych stylach i czasie trwania.

Choć rozwój EMO stwarza ekscytujące możliwości tworzenia spersonalizowanych treści wideo, rodzi także wątpliwości etyczne. Istnieje ryzyko niewłaściwego użycia, np personifikacja lub rozprzestrzenianie się mylna informacja. Dlatego też istotne jest ostrożne podejście do wdrażania takiej technologii i zapewnienie odpowiednich zabezpieczeń w celu rozwiązania tych problemów etycznych.

Synchronizacja ust Pika sprawia, że filmy generowane przez sztuczną inteligencję również mówią

Jak działa EMO?

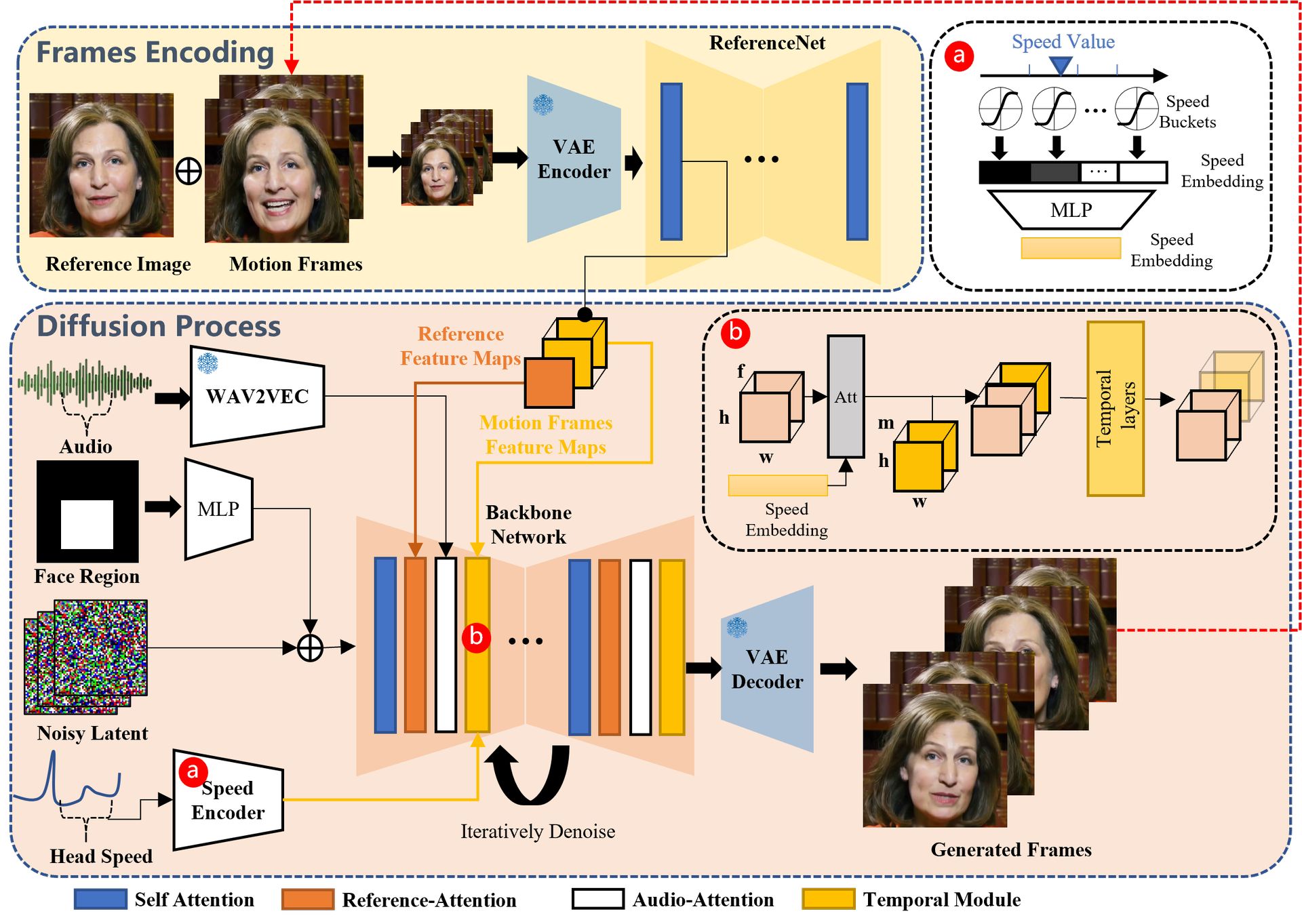

System EMO działa w dwóch głównych etapach: kodowania ramek i procesu dyfuzji.

- Kodowanie ramek: wyodrębnia funkcje z obrazów referencyjnych i klatek ruchu, aby stworzyć podstawę animacji.

- Proces dyfuzji: Wykorzystuje wstępnie wytrenowany koder audio do przetwarzania sygnału wejściowego audio. Integruje maski obszarów twarzy z szumem wieloklatkowym w celu generowania animacji. Sieć szkieletowa odszumia animacje, wspomagana przez mechanizmy Reference-Attention i Audio-Attention. Moduły czasowe dostosowują prędkość ruchu.

Co można zrobić z EMO?

EMO oferuje wszechstronne narzędzie do tworzenia realistycznych filmów animowanych, rozszerzające możliwości tworzenia spersonalizowanych i wyrazistych treści, takich jak:

- Śpiewanie: Generuje filmy z awatarami wokalnymi z wyrazistą mimiką zsynchronizowaną z wejściami audio śpiewu.

- Język i styl: Obsługuje różne języki i style portretów, rejestrując różnice tonalne na potrzeby dynamicznych animacji awatarów.

- Szybki rytm: Zapewnia synchronizację animacji postaci z szybkimi rytmami.

- Rozmawiając: Animuje portrety w odpowiedzi na dźwięk mówiony w różnych językach i stylach.

- Występ międzyaktorski: przedstawia postacie z filmów lub innych mediów w kontekstach wielojęzycznych i wielokulturowych.

Podsumowując, EMO, znane również jako Emote Portrait Alive, stanowi znaczący postęp w technologii animacji. Może przekształcić nieruchome zdjęcia w żywe filmy, w których postacie wydają się realistycznie mówić lub śpiewać. EMO osiąga to poprzez bezpośrednią konwersję dźwięku na klatki wideo, dokładnie rejestrując mimikę i ruchy twarzy. Chociaż EMO oferuje ekscytujące możliwości tworzenia dynamicznych treści wizualnych, należy uwzględnić kwestie etyczne dotyczące ich potencjalnego niewłaściwego wykorzystania. Niemniej jednak EMO stanowi cenne narzędzie ożywiania nieruchomych obrazów i może potencjalnie zmienić sposób, w jaki w przyszłości będziemy wchodzić w interakcję z mediami wizualnymi.

Aby uzyskać bardziej szczegółowe informacje, Tutaj jest jego artykułem naukowym.

Autor wyróżnionego obrazu: Badania EMO: Portret emotki na żywo